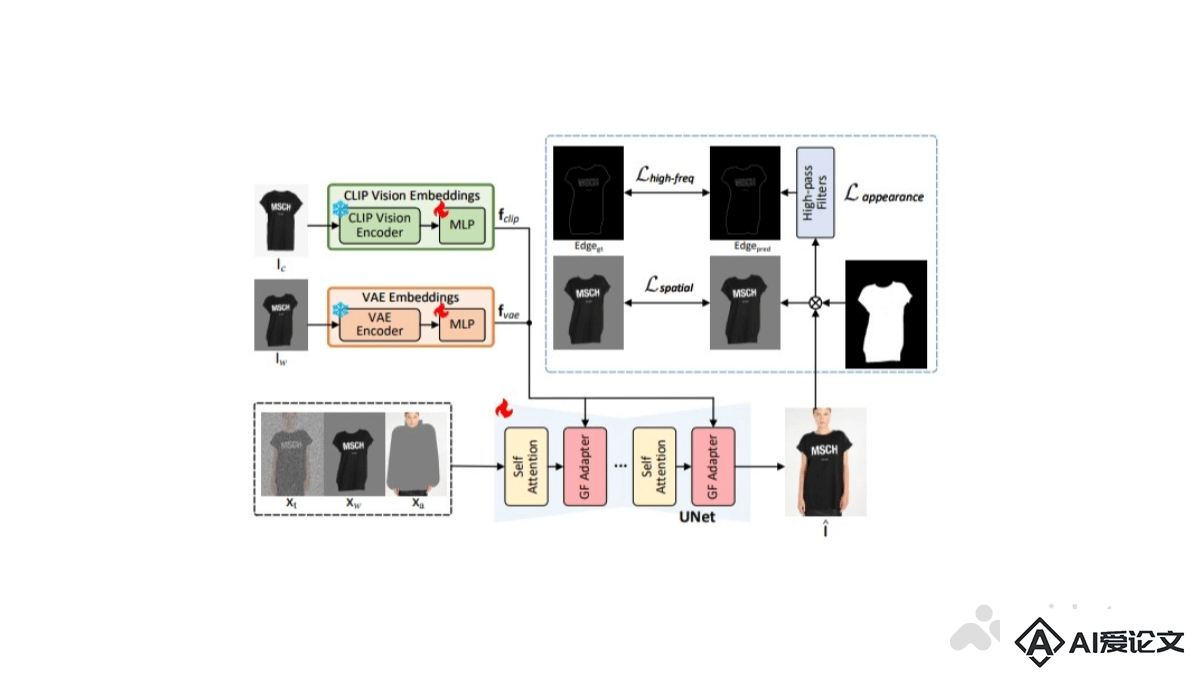

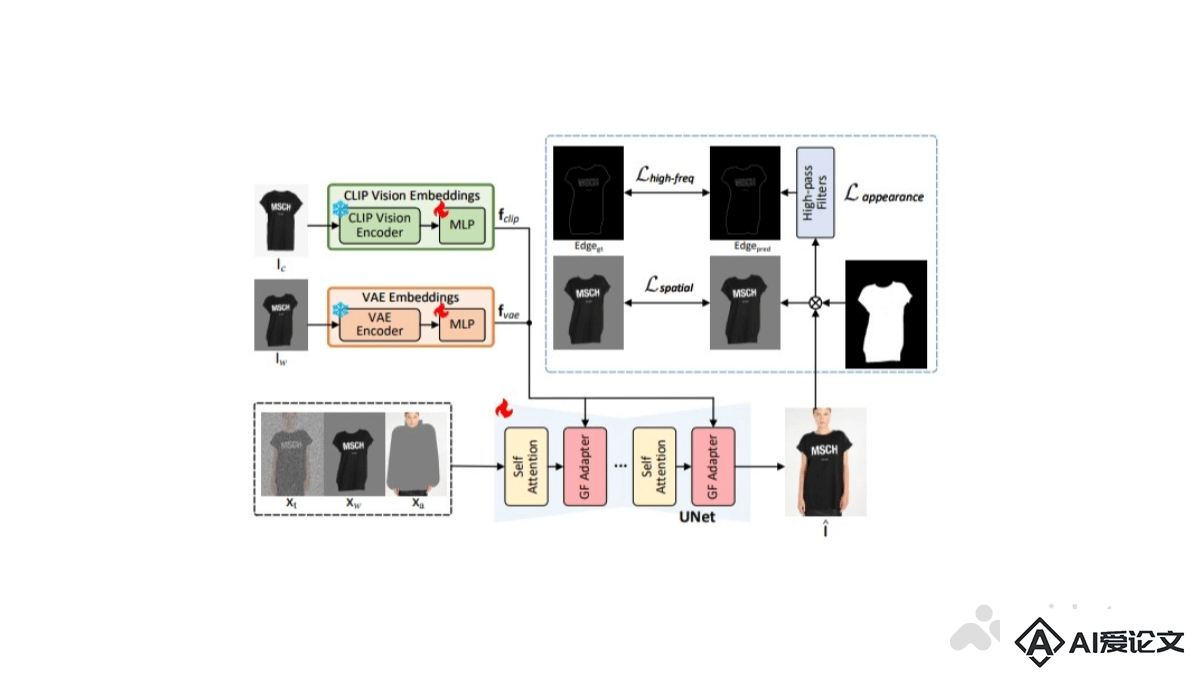

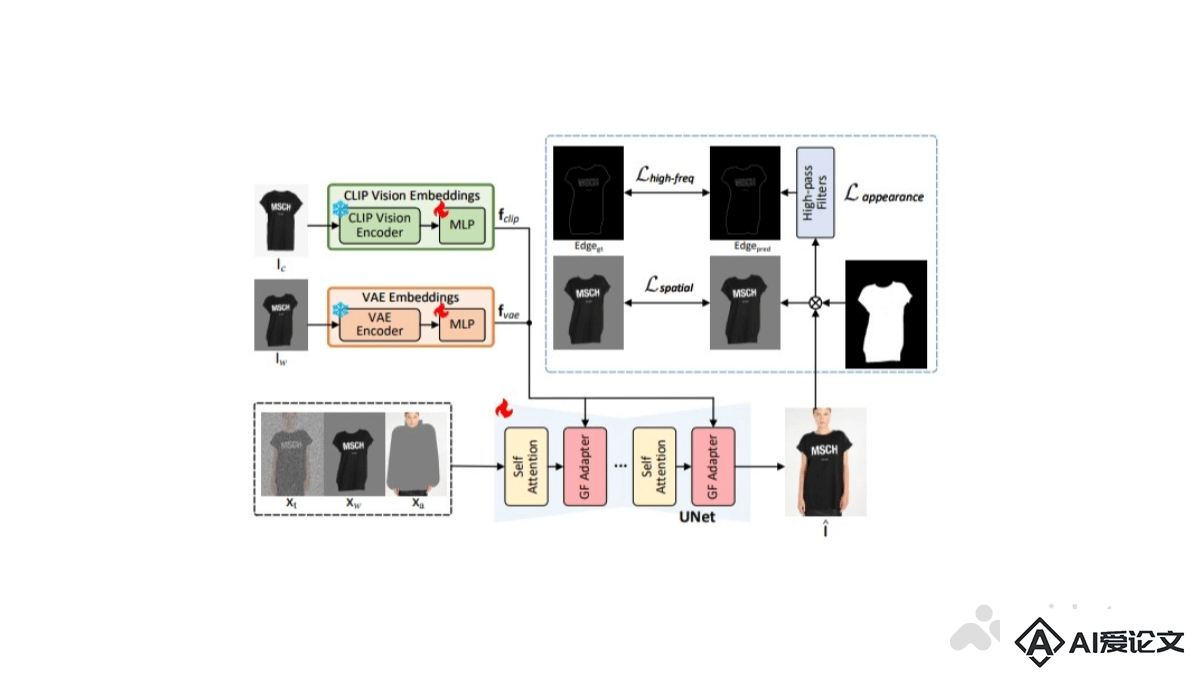

GarDiff是什么

GarDiff是一种创新的虚拟试穿技术,通过使用CLIP和VAE编码来提取服装的外观先验,结合服装聚焦适配器和高频细节增强算法,生成高保真且细节丰富的试穿图像。能精确地对齐服装与人体姿态,保留服装的复杂图案和纹理,提供真实的在线试穿体验。GarDiff在VITON-HD和DressCode数据集上的表现超越了现有技术,代码已开源,可供进一步研究和应用开发。

来源:爱论文 时间:2025-02-25 13:32:36

GarDiff是一种创新的虚拟试穿技术,通过使用CLIP和VAE编码来提取服装的外观先验,结合服装聚焦适配器和高频细节增强算法,生成高保真且细节丰富的试穿图像。能精确地对齐服装与人体姿态,保留服装的复杂图案和纹理,提供真实的在线试穿体验。GarDiff在VITON-HD和DressCode数据集上的表现超越了现有技术,代码已开源,可供进一步研究和应用开发。

相关资讯

更多+

相关资讯

更多+

GarDiff是一种创新的虚拟试穿技术,通过使用CLIP和VAE编码来提取服装的外观先验,结合服装聚焦适配器和高频细节增强算法,生成高保真且细节丰富的试穿图像。能精确地对齐服装与人体姿态,保留服装的复杂图案和纹理,提供真实的在线试穿体验。

AI教程资讯

2023-04-14

2023-04-14

NeMo 是由 NVIDIA 提供的端到端云原生框架,用于构建、定制和部署生成式 AI 模型。支持大型语言模型(LLMs)、多模态模型、语音识别和文本转语音(TTS)等应用。NeMo 的设计理念强调模块化和灵活性,使研究人员和企业用户能根据自己的需求选择和定制相应的AI模块。

AI教程资讯

2023-04-14

2023-04-14

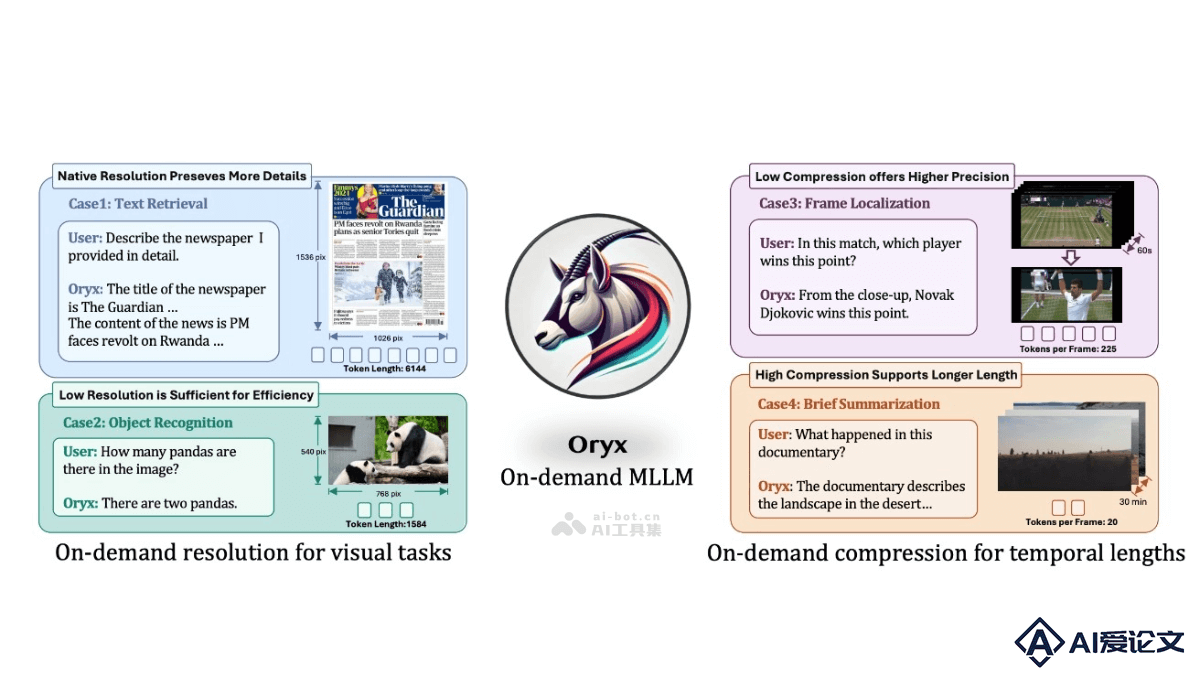

Oryx是由清华大学、腾讯和南洋理工大学联合推出的多模态大型语言模型(MLLM),基于两项核心创新来处理视觉数据,预训练的OryxViT模型和动态压缩模块。OryxViT将任意分辨率的图像编码为适合LLM的视觉表示,动态压缩模块根据需求在1到16倍之间压缩视觉标记。

AI教程资讯

2023-04-14

2023-04-14

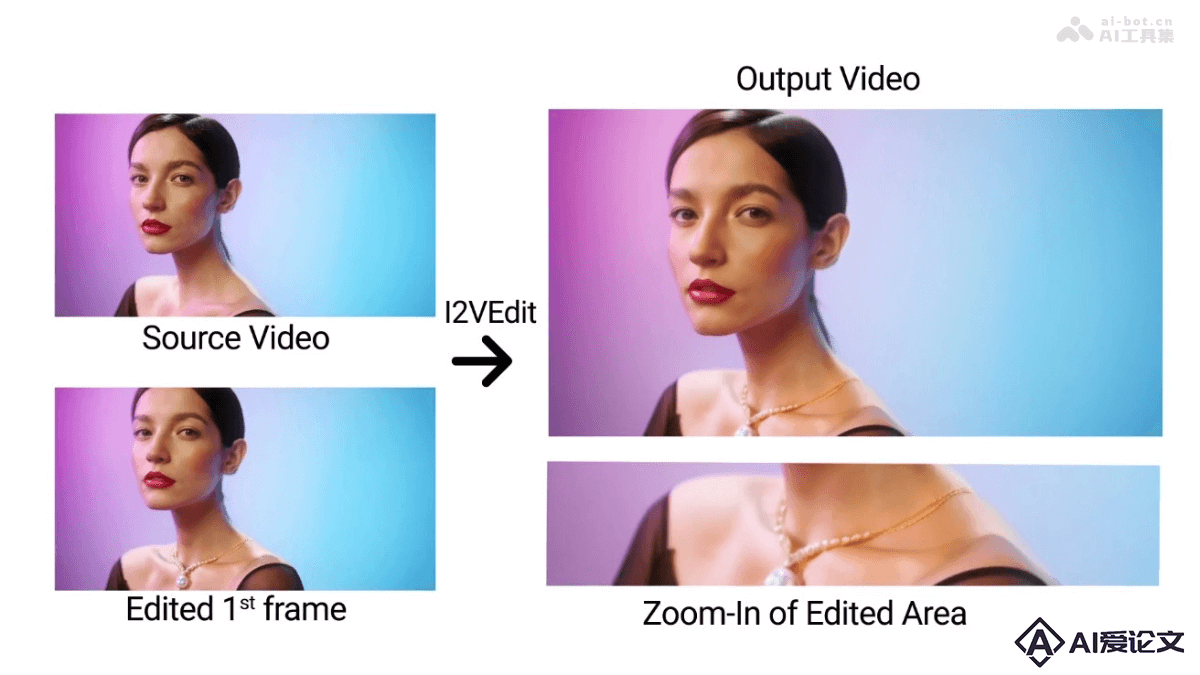

I2VEdit是一个先进的视频编辑框架,通过图像到视频的扩散模型实现首帧引导的视频编辑。用户只需编辑视频的第一帧,I2VEdit能自动将编辑效果应用到整个视频。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+