MotionCLR是什么

MotionCLR是基于注意力机制的人体动作生成和编辑模型,能根据文本提示生成动作,支持用户进行交互式编辑,如动作强调、减弱、替换、擦除和风格转移。MotionCLR基于自注意力和交叉注意力机制理解和编辑动作,支持多样化的动作编辑任务,如动作强调/减弱、原地动作替换、基于示例的动作生成等。模型在HumanML3D数据集上表现良好,生成的动作质量高,与文本描述的对齐精确,在多样性、可解释性和编辑能力方面均达到先进水平。

来源:爱论文 时间:2025-02-11 15:37:15

MotionCLR是基于注意力机制的人体动作生成和编辑模型,能根据文本提示生成动作,支持用户进行交互式编辑,如动作强调、减弱、替换、擦除和风格转移。MotionCLR基于自注意力和交叉注意力机制理解和编辑动作,支持多样化的动作编辑任务,如动作强调/减弱、原地动作替换、基于示例的动作生成等。模型在HumanML3D数据集上表现良好,生成的动作质量高,与文本描述的对齐精确,在多样性、可解释性和编辑能力方面均达到先进水平。

相关资讯

更多+

相关资讯

更多+

MotionCLR是基于注意力机制的人体动作生成和编辑模型,能根据文本提示生成动作,支持用户进行交互式编辑,如动作强调、减弱、替换、擦除和风格转移。MotionCLR基于自注意力和交叉注意力机制理解和编辑动作,支持多样化的动作编辑任务,如动作强调 减弱、原地动作替换、基于示例的动作生成等。

AI教程资讯

2023-04-14

2023-04-14

DocMind是司马阅推出的文档智能大模型,基于Transformer结构,融合深度学习、NLP和CV技术,能处理富文本文档的复杂结构和视觉信息,提高信息抽取准确性。DocMind支持精准识别文档实体、捕捉文本依赖关系、深入理解文档内容,能与知识库结合,提升专业文档理解。

AI教程资讯

2023-04-14

2023-04-14

DistilQwen2是基于Qwen2大模型用知识蒸馏技术优化得到的轻量级语言模型,能提高运算效率和降低部署成本。DistilQwen2基于深度剖析大模型、增强指令数据多样性和优化蒸馏算法,将复杂知识传递给小模型,提升指令遵循效果。

AI教程资讯

2023-04-14

2023-04-14

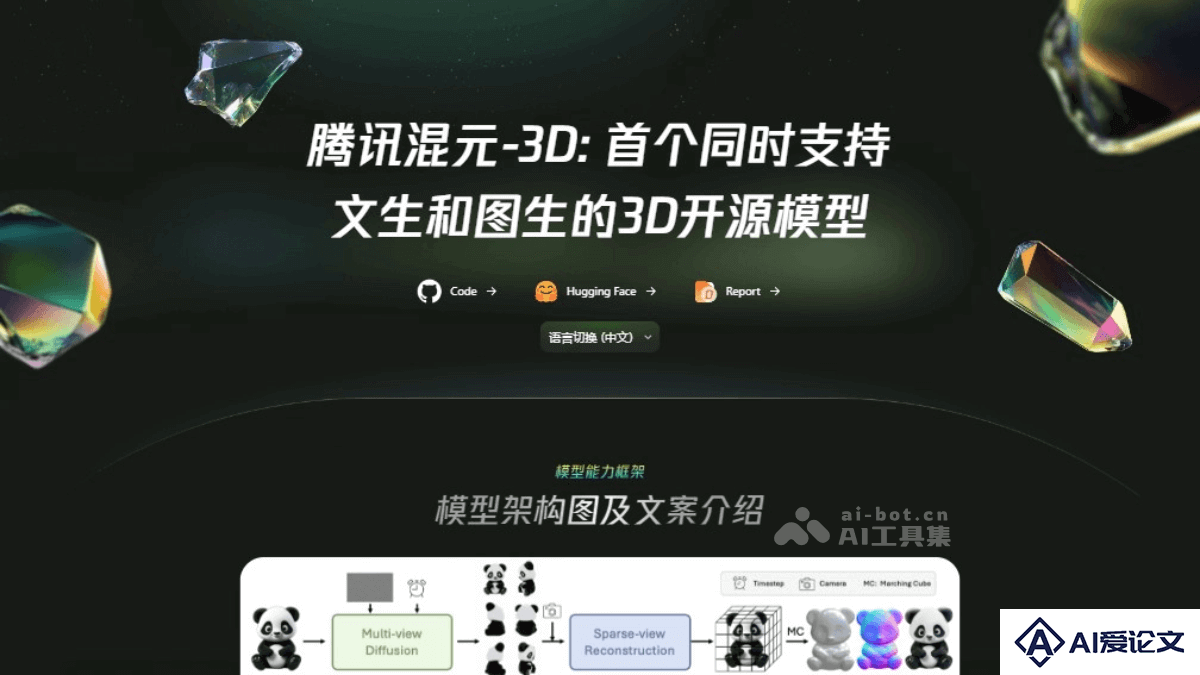

Hunyuan3D-1 0 是腾讯推出的一款3D生成模型,具备文本和图像输入条件,支持高质量的3D资产生成。该模型采用两阶段方法,首先使用多视角扩散模型生成多视角RGB图像,然后利用基于Transformer的稀疏视角大规模重建模型,将这些图像转换为3D资产。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+

AI工具推荐

更多+

AI工具推荐

更多+