AdaCache是什么

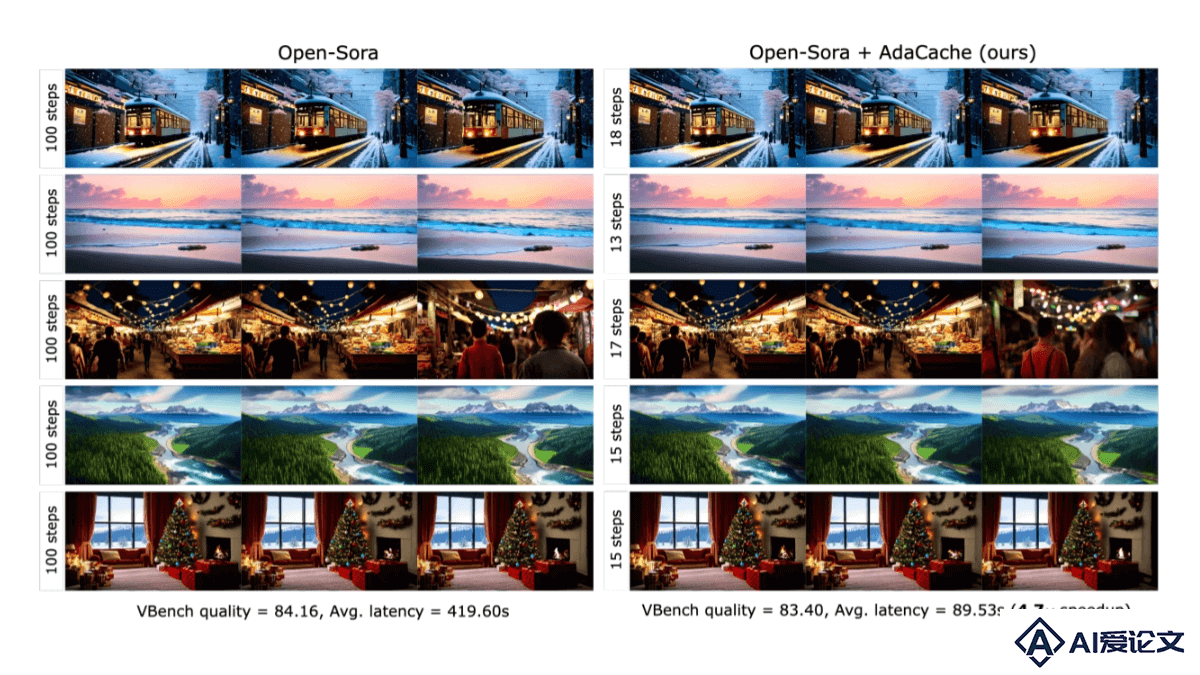

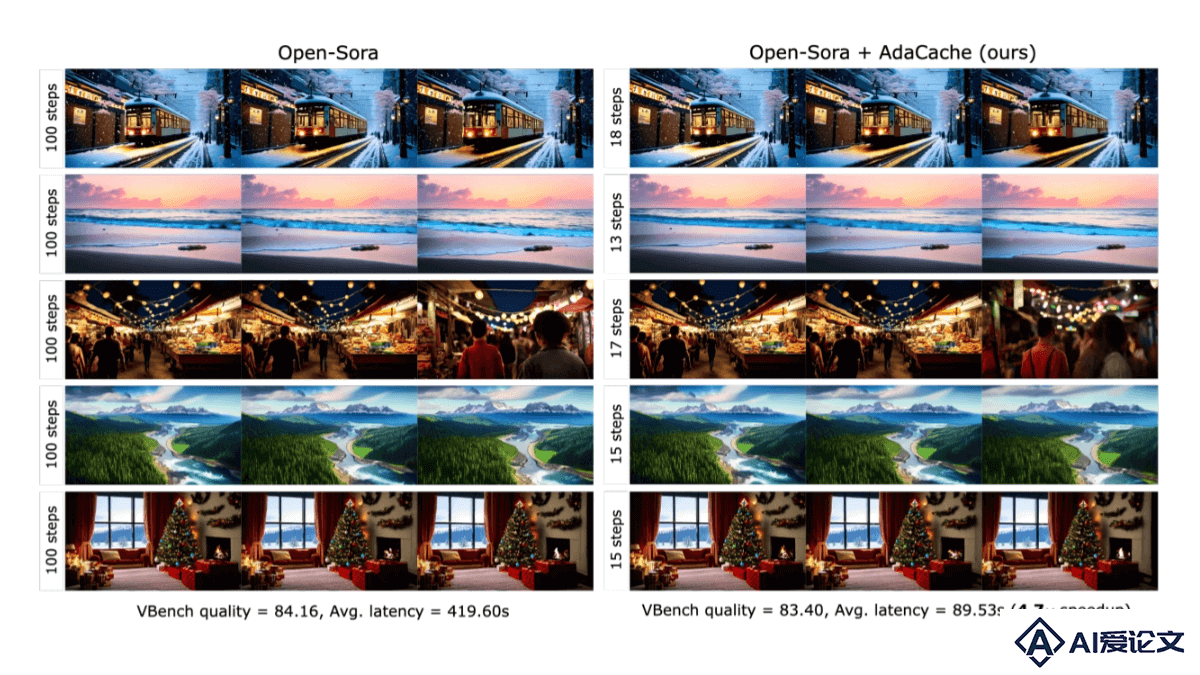

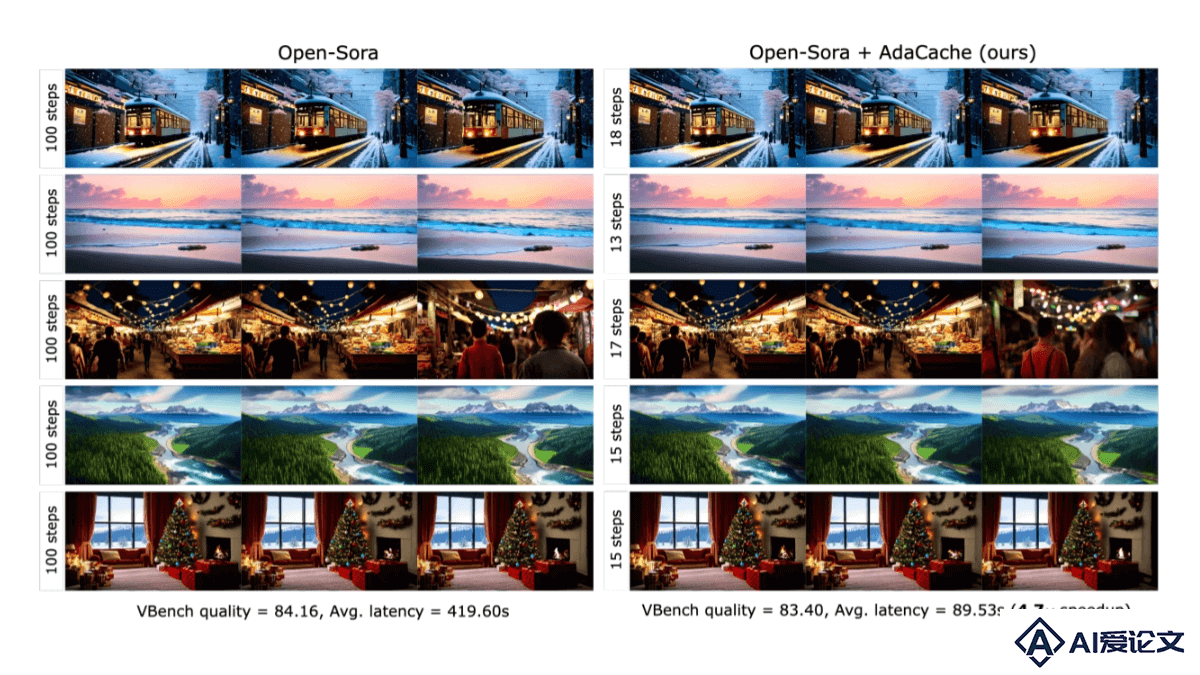

AdaCache(Adaptive Caching)是Meta推出的开源技术,能加速AI视频生成过程。AdaCache自适应缓存机制优化计算资源分配,根据不同视频内容的复杂度动态调整计算量,减少不必要的计算开销。AdaCache引入运动正则化策略,用视频内的运动信息进一步优化缓存决策。实验表明,AdaCache在保持视频质量的同时,显著提升生成速度,在多GPU环境下效果显著,对视频生成领域具有重要的应用价值和发展前景。

来源:爱论文 时间:2025-02-10 14:08:45

AdaCache(Adaptive Caching)是Meta推出的开源技术,能加速AI视频生成过程。AdaCache自适应缓存机制优化计算资源分配,根据不同视频内容的复杂度动态调整计算量,减少不必要的计算开销。AdaCache引入运动正则化策略,用视频内的运动信息进一步优化缓存决策。实验表明,AdaCache在保持视频质量的同时,显著提升生成速度,在多GPU环境下效果显著,对视频生成领域具有重要的应用价值和发展前景。

相关资讯

更多+

相关资讯

更多+

AdaCache(Adaptive Caching)是Meta推出的开源技术,能加速AI视频生成过程。AdaCache自适应缓存机制优化计算资源分配,根据不同视频内容的复杂度动态调整计算量,减少不必要的计算开销。AdaCache引入运动正则化策略,用视频内的运动信息进一步优化缓存决策。

AI教程资讯

2023-04-14

2023-04-14

CogVideoX v1 5是智谱最新开源的AI视频生成模型。模型包含CogVideoX v1 5-5B和CogVideoX v1 5-5B-I2V两个版本,5B 系列模型支持生成5至10秒、768P分辨率、16帧的视频,I2V模型能处理任意尺寸比例的图像到视频的转换,结合即将开放内测的CogSound音效模型能自动生成匹配的AI音效。

AI教程资讯

2023-04-14

2023-04-14

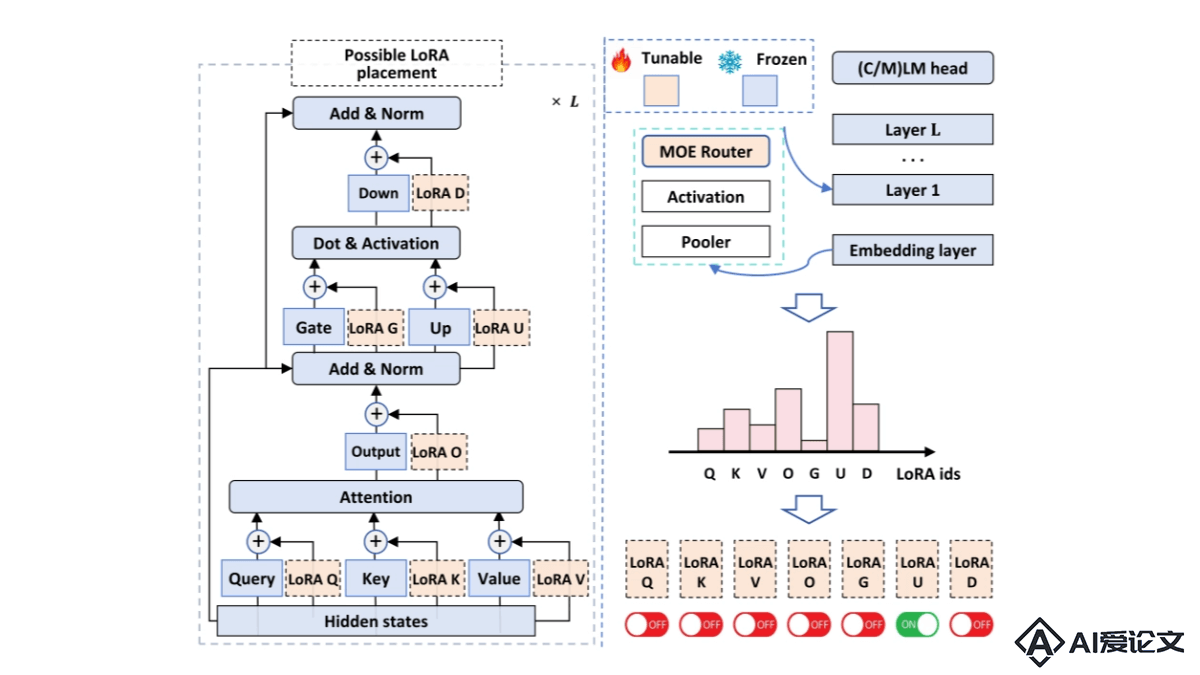

MiLoRA是参数高效的大型语言模型(LLMs)微调方法,通过更新权重分量来矩阵的次要奇异减少计算和内存成本。方法基于奇异值分解(SVD)将权重矩阵分为主要和次要两部分,主要部分包含重要知识,次要部分包含噪声或长尾信息。

AI教程资讯

2023-04-14

2023-04-14

OpenCoder是墨尔本大学、复旦大学等高校研究人员联合无限光年推出的开源代码大型语言模型(LLM),能提升开源代码LLM的性能至专有模型水平,推动代码AI研究的透明化和可重复性。OpenCoder提供模型权重和推理代码,包括可复现的训练数据、完整的数据处理流程、严格的实验消融结果和详细的训练协议,助力研究社区构建和创新。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+

AI工具推荐

更多+

AI工具推荐

更多+