HART – 麻省理工学院推出的自回归视觉生成模型

来源:爱论文

时间:2025-02-02 22:09:15

HART是什么

HART(Hybrid Autoregressive Transformer)是麻省理工学院研究团队推出的自回归视觉生成模型。能直接生成1024×1024像素的高分辨率图像,质量媲美扩散模型。HART基于混合Tokenizer技术,将自动编码器的连续潜在表示分解为离散token和连续token,其中离散token负责捕捉图像的主要结构,连续token专注于细节。HART的轻量级残差扩散模块仅用3700万参数,大幅提升计算效率。在MJHQ-30K数据集上,HART将重构FID从2.11降至0.30,生成FID从7.85降至5.38,提升了31%,在吞吐量上比现有扩散模型提高4.5-7.7倍,MAC降低6.9-13.4倍。

HART的主要功能

高分辨率图像生成:直接生成1024×1024像素的高分辨率图像,满足高质量视觉内容的需求。图像质量提升:基于混合Tokenizer技术,HART在图像重建和生成质量上超越传统的自回归模型,与扩散模型相媲美。计算效率优化:在保持高图像质量的同时,显著提高计算效率,降低训练成本和推理延迟。自回归建模:基于自回归方法,逐步生成图像,支持对生成过程进行更精细的控制。

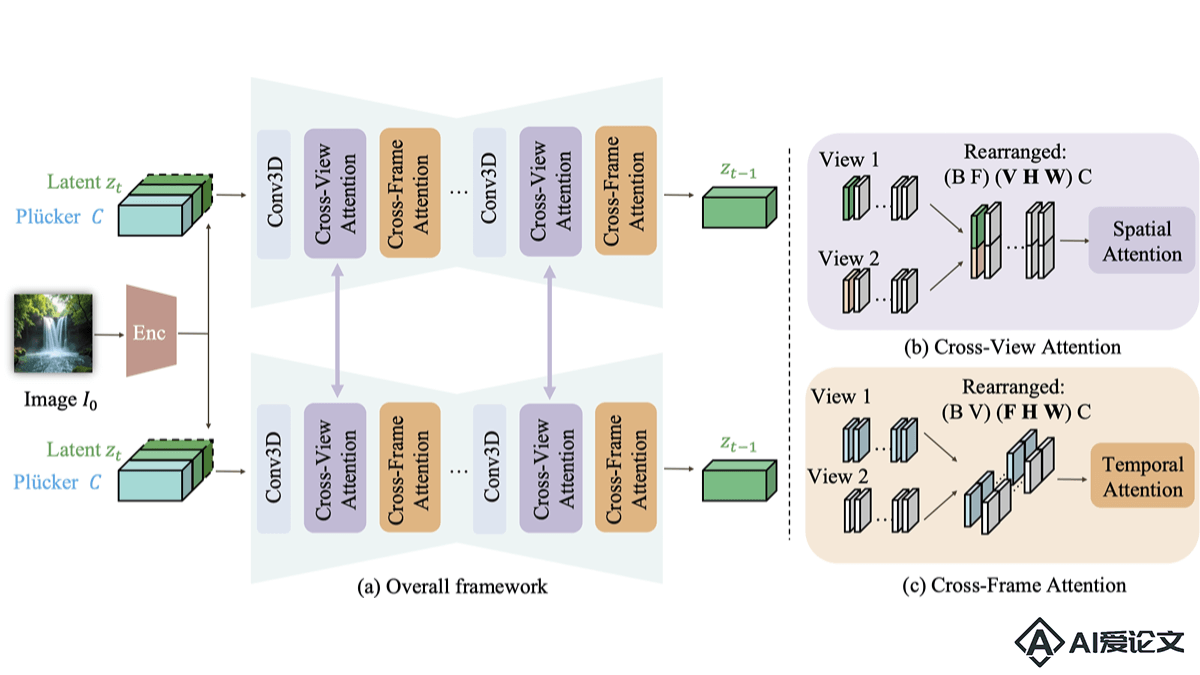

HART的技术原理

混合Tokenizer:HART的核心是混合Tokenizer,将自动编码器的连续潜在表示分解为离散token和连续token。离散token负责捕捉图像的主要结构,连续token专注于细节。离散自回归模型:离散部分由一个可扩展分辨率的离散自回归模型建模,支持模型在不同分辨率下生成图像。轻量级残差扩散模块:连续部分由一个轻量级的残差扩散模块学习,该模块只有3700万个参数,有助于提高模型的效率。效率与性能平衡:HART在FID和CLIP分数上优于现有的扩散模型,在吞吐量上提高了4.5-7.7倍,MAC降低6.9-13.4倍,实现效率与性能的良好平衡。自回归生成:HART基于自回归方法,逐步生成图像,每一步都基于前一步的输出,支持模型在生成过程中逐步细化图像细节。

HART的项目地址

项目官网:hanlab.mit.edu/projects/hartGitHub仓库:https://github.com/mit-han-lab/hartarXiv技术论文:https://arxiv.org/pdf/2410.10812在线体验Demo:https://hart.mit.edu/

HART的应用场景

数字艺术创作:艺术家和设计师生成高质量的数字艺术作品,包括插图、概念艺术和视觉特效。游戏开发:在游戏设计中,生成游戏资产,如角色、环境和道具的高分辨率图像。电影和视频制作:生成电影海报、概念艺术或者作为视频内容的背景和特效。广告和营销:营销团队快速生成吸引人的广告图像和营销材料。社交媒体内容:用户为社交媒体平台生成个性化的图像和视觉内容。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载