SAM 2.1是什么

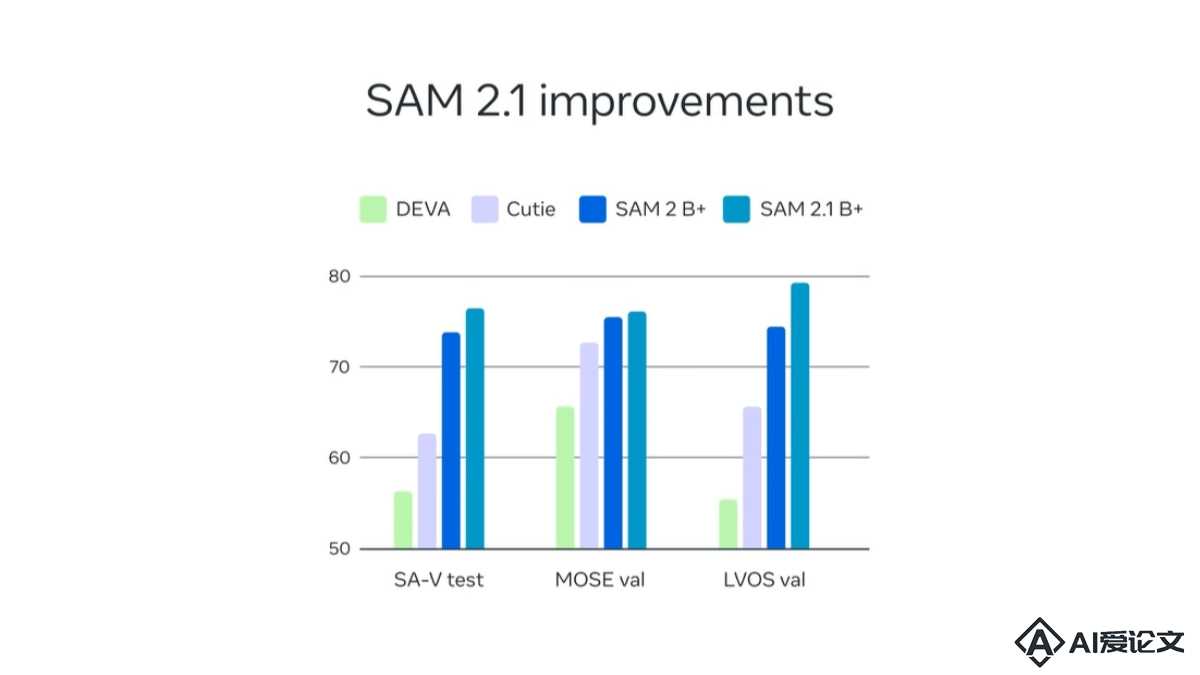

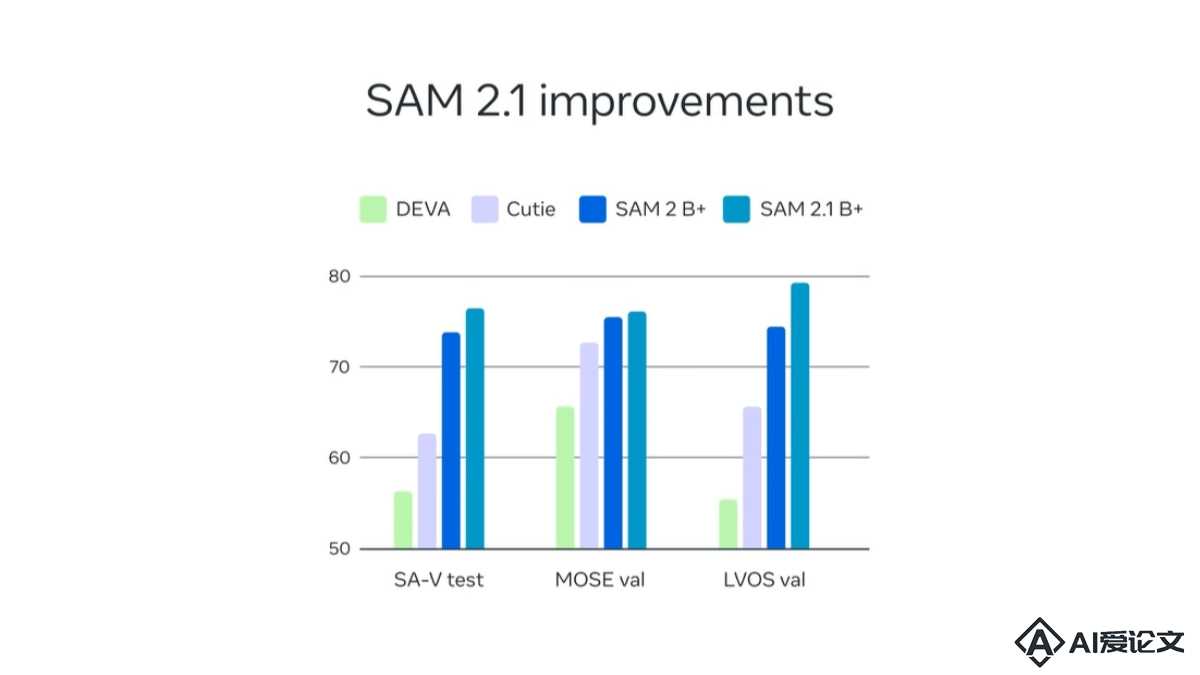

SAM 2.1(全称Segment Anything Model 2.1)是Meta(Facebook的母公司)推出的先进视觉分割模型,用于图像和视频。基于简单的Transformer架构和流式记忆设计,实现实时视频处理。SAM 2.1在前代基础上引入数据增强技术,改善对视觉相似物体和小物体的识别,提升遮挡处理能力。此外Meta开源了SAM 2的开发者套件,包括训练代码和网络演示的前后端代码,方便用户使用和微调模型。

来源:爱论文 时间:2025-01-31 20:41:40

SAM 2.1(全称Segment Anything Model 2.1)是Meta(Facebook的母公司)推出的先进视觉分割模型,用于图像和视频。基于简单的Transformer架构和流式记忆设计,实现实时视频处理。SAM 2.1在前代基础上引入数据增强技术,改善对视觉相似物体和小物体的识别,提升遮挡处理能力。此外Meta开源了SAM 2的开发者套件,包括训练代码和网络演示的前后端代码,方便用户使用和微调模型。

相关资讯

更多+

相关资讯

更多+

SAM 2 1(全称Segment Anything Model 2 1)是Meta(Facebook的母公司)推出的先进视觉分割模型,用于图像和视频。基于简单的Transformer架构和流式记忆设计,实现实时视频处理。SAM 2 1在前代基础上引入数据增强技术,改善对视觉相似物体和小物体的识别,提升遮挡处理能力。

AI教程资讯

2023-04-14

2023-04-14

Qwen2VL-Flux是多模态图像生成模型,结合Qwen2VL的视觉语言理解和FLUX框架,基于文本提示和图像参考生成高质量的图像。模型支持多种生成模式,包括变体生成、图像到图像转换、智能修复及ControlNet引导生成,具备深度估计和线条检测功能,实现更精确的图像控制。

AI教程资讯

2023-04-14

2023-04-14

ShowUI是新加坡国立大学Show Lab和微软共同推出的视觉-语言-行动模型,能提升图形用户界面(GUI)助手的工作效率。模型基于UI引导的视觉令牌选择减少计算成本,用交错视觉-语言-行动流统一GUI任务中的多样化需求,并管理视觉-行动历史增强训练效率。

AI教程资讯

2023-04-14

2023-04-14

NVLM是NVIDIA推出的前沿多模态大型语言模型(LLMs),在视觉-语言任务上达到与顶尖专有模型(如GPT-4o)和开放访问模型(如Llama 3-V 405B和InternVL 2)相匹敌的性能。NVLM 1 0家族包括三种架构:仅解码器模型NVLM-D、基于交叉注意力的模型NVLM-X和混合架构NVLM-H。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+

AI工具推荐

更多+

AI工具推荐

更多+