iDP3是什么

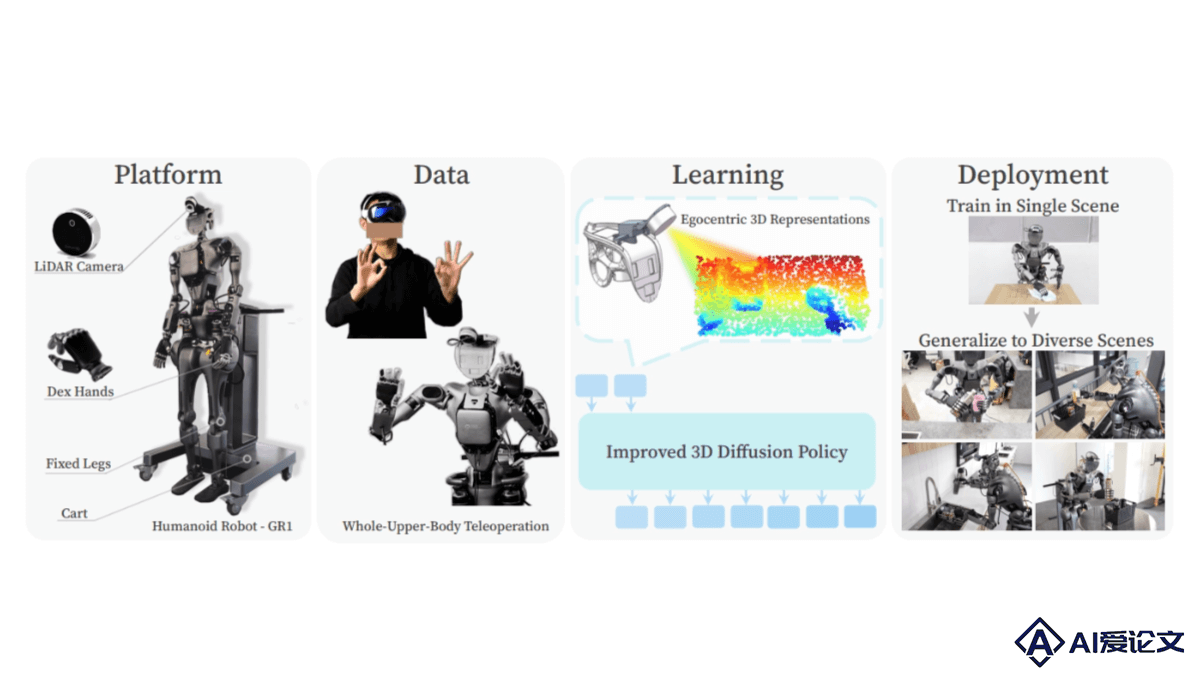

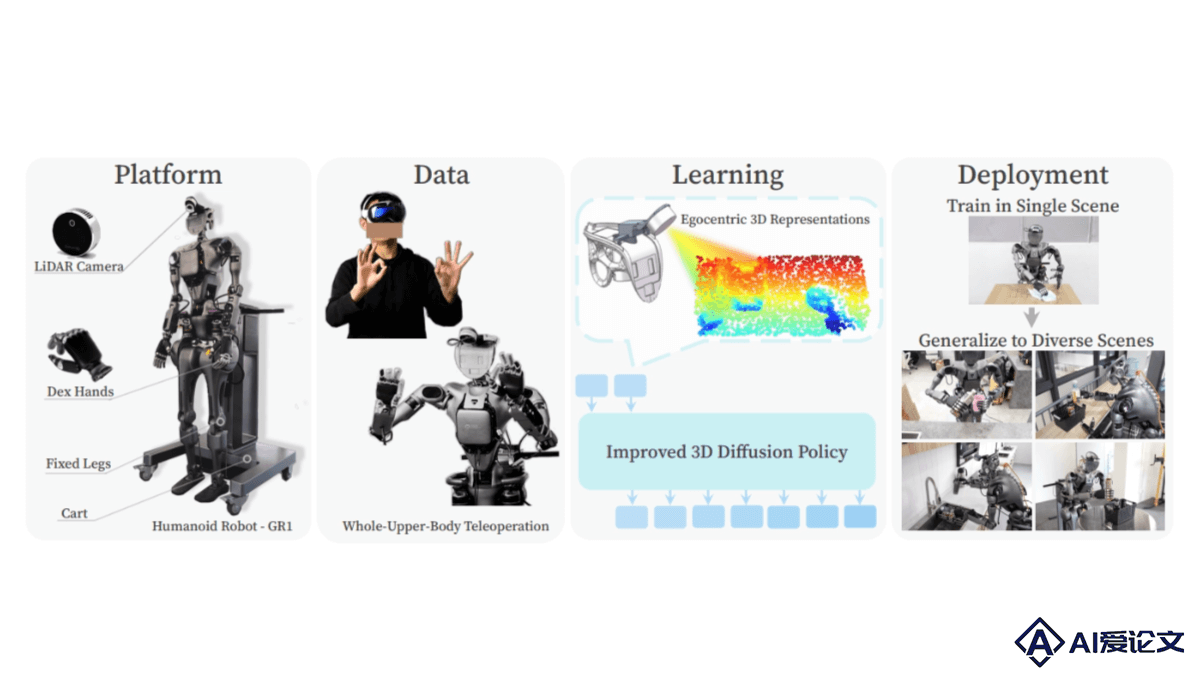

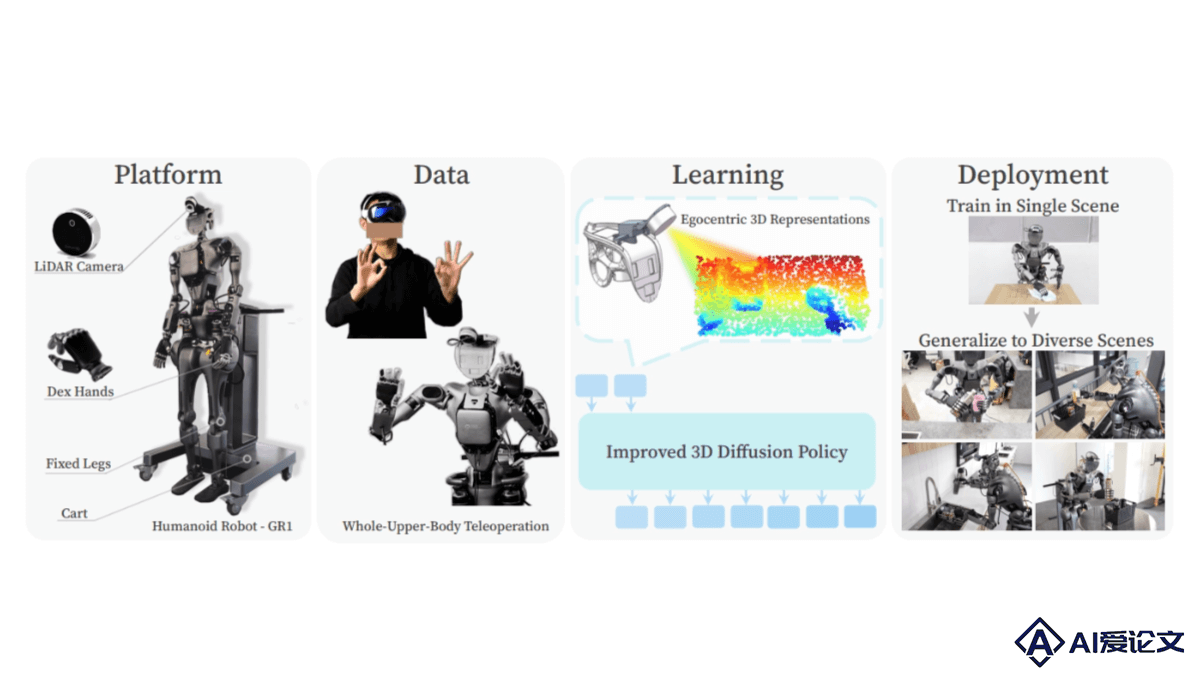

iDP3(Improved 3D Diffusion Policy)是斯坦福大学联合多所高校推出的改进型3D视觉运动策略(如三维扩散策略),提升人形机器人在多样化环境中的自主操作能力。与传统3D策略不同,iDP3基于自我中心的3D视觉表征,摒弃对精确相机校准和点云分割的需求,让机器人能灵活地在真实世界中执行任务。iDP3在视图变化、新对象识别和新场景适应方面展现出卓越的泛化能力,显著提高人形机器人在未见过的环境中的实用性和灵活性。

来源:爱论文 时间:2025-01-31 17:39:27

iDP3(Improved 3D Diffusion Policy)是斯坦福大学联合多所高校推出的改进型3D视觉运动策略(如三维扩散策略),提升人形机器人在多样化环境中的自主操作能力。与传统3D策略不同,iDP3基于自我中心的3D视觉表征,摒弃对精确相机校准和点云分割的需求,让机器人能灵活地在真实世界中执行任务。iDP3在视图变化、新对象识别和新场景适应方面展现出卓越的泛化能力,显著提高人形机器人在未见过的环境中的实用性和灵活性。

相关资讯

更多+

相关资讯

更多+

iDP3(Improved 3D Diffusion Policy)是斯坦福大学联合多所高校推出的3D视觉运动策略,能提升人形机器人在多样化环境中的自主操作能力。与传统3D策略不同,iDP3基于自我中心的3D视觉表征,摒弃对精确相机校准和点云分割的需求,让机器人能灵活地在真实世界中执行任务。

AI教程资讯

2023-04-14

2023-04-14

Proactive Agent是清华大学联合面壁智能等团队推出的新一代主动Agent交互范式 ,具备主动性,能预测用户需求并在没有直接指令的情况下采取行动。Proactive Agent观察环境和用户行为,推断出潜在的任务,并自主提供帮助。

AI教程资讯

2023-04-14

2023-04-14

EMOVA(EMotionally Omni-present Voice Assistant)是多模态全能模型,是香港科技大学、香港大学和华为诺亚方舟实验室等机构共同推出的。EMOVA能处理图像、文本和语音模态,实现能看、能听、会说的全模态交互。

AI教程资讯

2023-04-14

2023-04-14

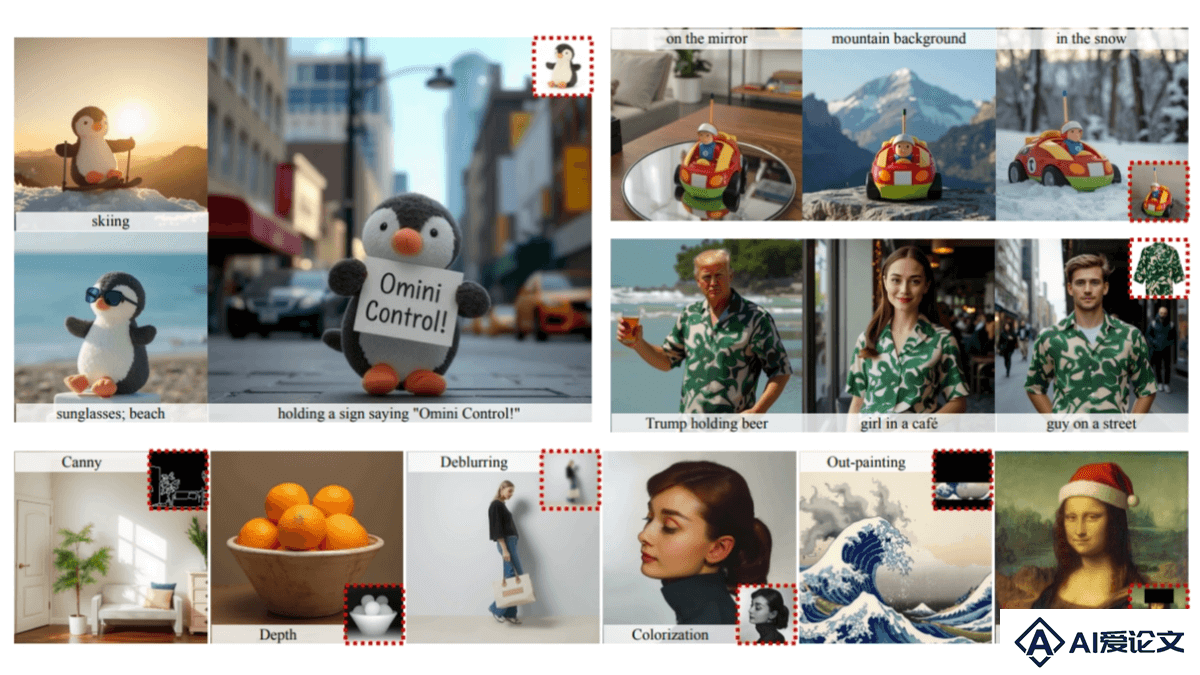

OminiControl是高度通用且参数高效的图像生成框架,为扩散变换器模型如FLUX 1设计,实现对图像生成过程的精细控制。OminiControl支持主题驱动控制和空间控制,例如边缘引导和绘画生成,仅需在基础模型中增加0 1%的参数。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+

AI工具推荐

更多+

AI工具推荐

更多+