POINTS 1.5 – 腾讯微信推出的多模态大模型

来源:爱论文

时间:2025-01-24 10:00:08

POINTS 1.5是什么

POINTS 1.5 是腾讯微信发布的多模态大模型,是POINTS 1.0的升级版本。 模型继续沿用了POINTS 1.0中的LLaVA架构,由一个视觉编码器、一个投影器和一个大型语言模型组成。 POINTS 1.5在效率和性能上都进行了增强,特别是在全球10B以下开源模型的排名中,POINTS 1.5-7B位居榜首,超越了其他业界领先的模型,如Qwen2-VL、InternVL2和MiniCPM-V-2.5等。 POINTS 1.5在复杂场景的OCR、推理能力、关键信息提取、LaTeX公式提取、数学、图片翻译、物体识别等方面有不错的表现。

POINTS 1.5的主要功能

复杂场景的OCR(光学字符识别):POINTS 1.5能在复杂场景中进行有效的文字识别。推理能力:模型具备强大的推理能力,能理解和处理复杂的逻辑问题。关键信息提取:能从大量数据中提取关键信息,提高信息处理的效率和准确性。LaTeX公式提取:模型能识别并提取LaTeX格式的数学公式。数学问题处理:POINTS 1.5能理解和解决数学问题,在数学领域的应用潜力。图片翻译:模型能对图片内容进行翻译,适用在多语言环境下。物体识别:POINTS 1.5能识别图片中的物体,应用于图像分析和理解。

POINTS 1.5的技术原理

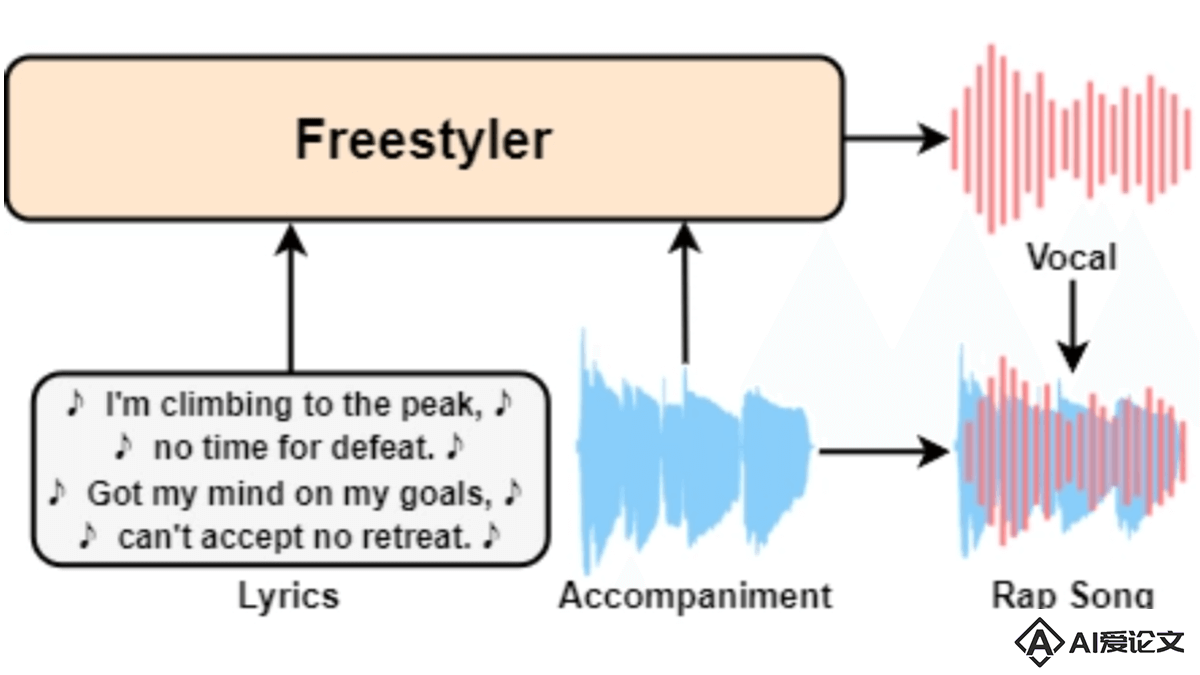

视觉编码器(Vision Encoder):负责处理输入的图像数据,提取图像特征。使用深度学习中的卷积神经网络(CNN)来实现,能捕捉图像中的空间层次结构和语义信息。投影器(Projector):将视觉编码器提取的图像特征映射到一个适合与语言模型交互的特征空间。涉及到特征的降维和转换,确保图像特征和文本特征在同一个空间中有效对齐。大型语言模型(Large Language Model):处理文本输入,生成语言相关的输出。是一个预训练的Transformer模型,能理解自然语言,生成连贯、有意义的文本响应。数据输入:模型接收图像和/或文本数据作为输入。图像数据通过视觉编码器进行处理,文本数据则直接输入到语言模型。特征提取:视觉编码器提取图像的关键特征,特征包括颜色、形状、纹理等视觉信息。同时,语言模型提取文本的语义特征,理解文本的含义和上下文。特征融合:通过投影器,图像特征被转换到一个适合与文本特征结合的共同特征空间。在这个空间中,图像和文本特征可以相互补充,形成一个统一的多模态特征表示。任务处理:融合后的多模态特征被用于执行特定的任务,如图像描述、视觉问答、文本到图像的生成等。模型能根据任务需求,生成相应的输出,如描述图像内容的文本、回答与图像相关的问题等。

POINTS 1.5的项目地址

Github仓库:https://github.com/WePOINTS/WePOINTSHuggingFace模型库:https://huggingface.co/WePOINTSarXiv技术论文:https://arxiv.org/pdf/2412.08443

POINTS 1.5的应用场景

票据识别:自动识别和提取发票、收据等票据上的文字信息。自动客服:通过理解用户的问题并提供逻辑推理,自动回答用户咨询。新闻摘要:从长篇新闻报道中提取关键信息,生成摘要。学术论文处理:从学术论文中提取数学公式,进一步的编辑和分析。旅游翻译:在旅游时,通过手机拍摄路标、菜单等,实时翻译成目标语言。在线教育平台:辅助学生解答数学题,提供解题步骤和答案。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载