UniFluid – 谷歌联合麻省理工推出的多模态图像生成与理解框架

来源:爱论文

时间:2025-04-21 10:40:23

UniFluid是什么

UniFluid 是谷歌 DeepMind 和麻省理工学院联合推出的,统一的自回归框架,用在联合视觉生成和理解任务。基于连续视觉标记处理多模态图像和文本输入,生成离散文本标记和连续图像标记。框架基于预训练的 Gemma 模型,用配对的图像-文本数据训练,让生成和理解任务相互促进。UniFluid 基于标准的 SentencePiece 作为文本标记器,用连续变分自编码器(VAE)作为图像生成的标记器,结合 SigLIP 图像编码器用在理解任务。基于精心调整训练配方和损失权重平衡,UniFluid 在图像生成和理解任务上均取得与单任务基线相当或更优的结果,展现出强大的下游任务迁移能力,包括图像编辑、视觉描述和问答等。

UniFluid的主要功能

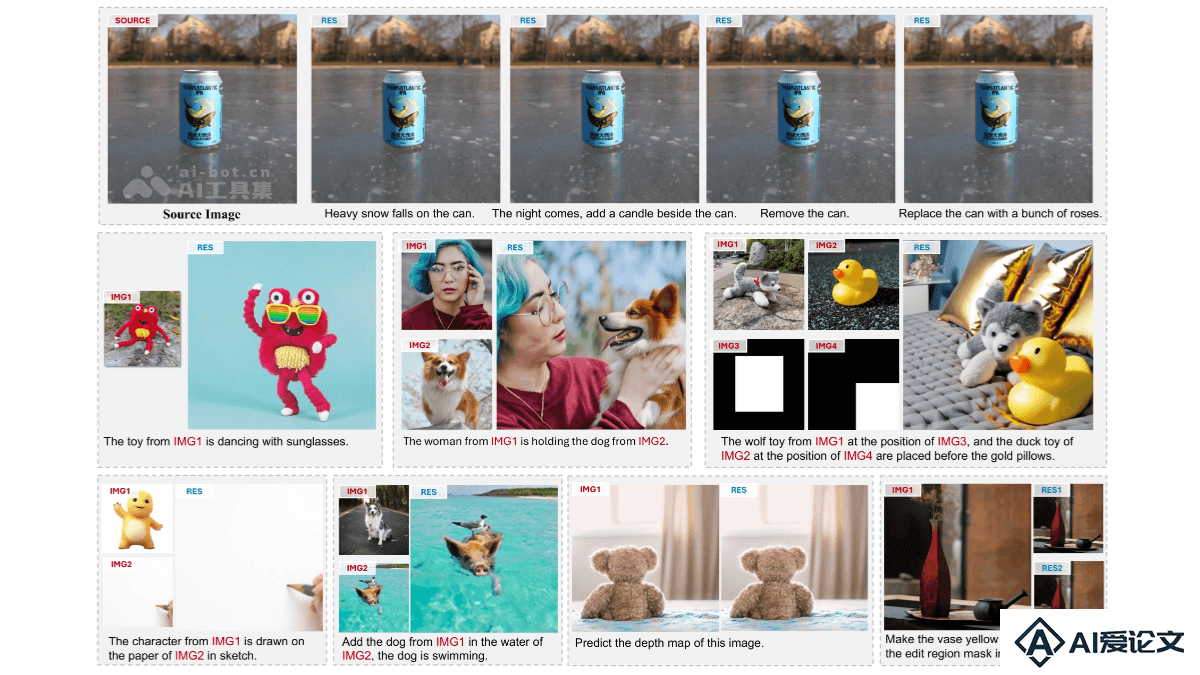

联合视觉生成和理解:同时处理图像生成(如根据文本描述生成图像)和视觉理解(如图像描述、视觉问答)任务。多模态输入处理:支持图像和文本的多模态输入,将图像和文本嵌入到同一空间进行联合训练。高质量图像生成:基于连续视觉标记生成高质量图像,支持随机生成顺序以提升生成效果。强大的视觉理解能力:在视觉问答、图像描述等任务上表现出色,支持多种下游任务。高效的下游任务迁移:快速适应图像编辑、视觉问答等下游任务,展现出良好的通用性和可扩展性。

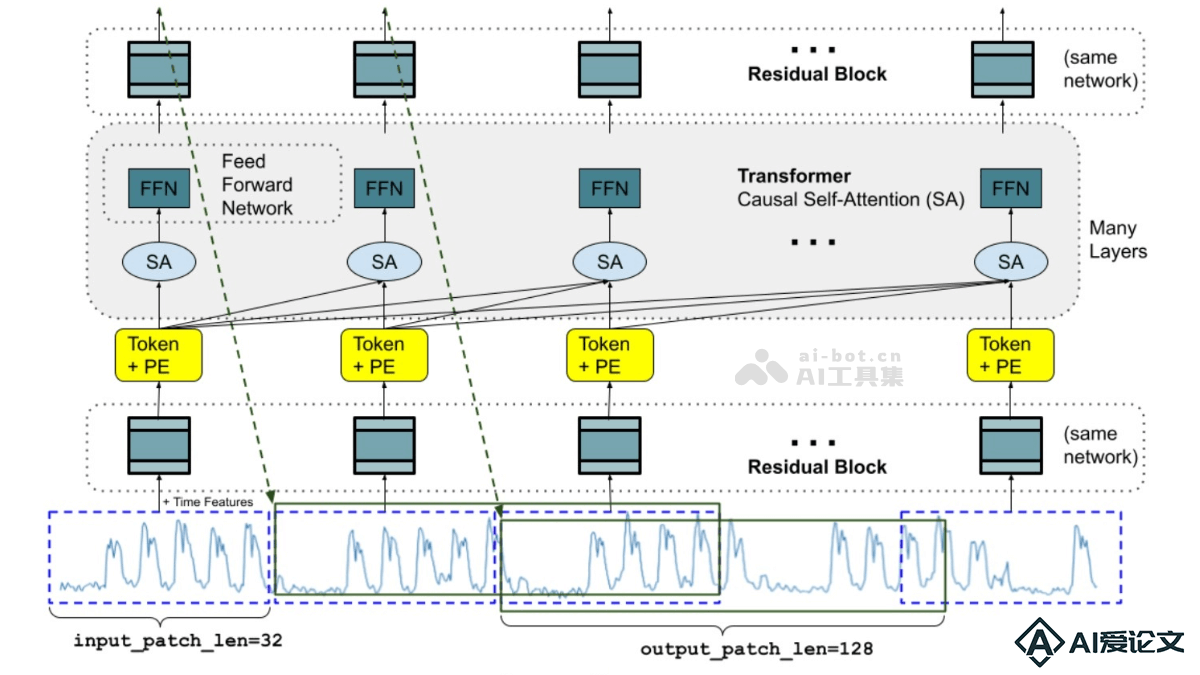

UniFluid的技术原理

统一自回归框架:UniFluid 用自回归模型,将图像和文本输入嵌入到同一空间,基于“下一个标记预测”统一处理视觉生成和理解任务。连续视觉标记:图像用连续变分自编码器(VAE)编码为连续标记,避免离散标记带来的信息损失,保留了图像的连续性。模态特定的预测头:分类头处理文本生成任务,扩散头处理图像生成任务,确保在不同模态下都能进行有效的训练和推理。随机生成顺序:在图像生成任务中,基于随机顺序生成图像标记,避免因固定顺序(如光栅顺序)导致的生成问题。损失函数平衡:调整图像生成和文本理解任务的损失权重,实现两个任务之间的平衡,让模型在生成和理解任务上表现出色。预训练的大型语言模型(LLM):基于预训练的 Gemma 模型,用其强大的语言和视觉理解能力,提升模型的整体性能。

UniFluid的项目地址

arXiv技术论文:https://arxiv.org/pdf/2503.13436

UniFluid的应用场景

图像生成:在创意设计、广告制作、游戏开发等领域,根据用户输入的文本描述快速生成相应的图像内容。图像编辑:在照片编辑、数字艺术创作等场景,添加或删除对象、改变风格、调整颜色等。视觉问答(VQA):在教育、智能客服、辅助视觉障碍人士等领域,帮助用户更好地理解和解释图像信息。图像描述(Image Captioning):自动生成图像的描述文本,用在社交媒体内容生成、图像搜索引擎优化、辅助视觉障碍人士理解图像等。多模态内容创作:在视频脚本创作、虚拟现实(VR)和增强现实(AR)内容开发中,提供更生动的视觉和语言体验。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载