UniAct是什么

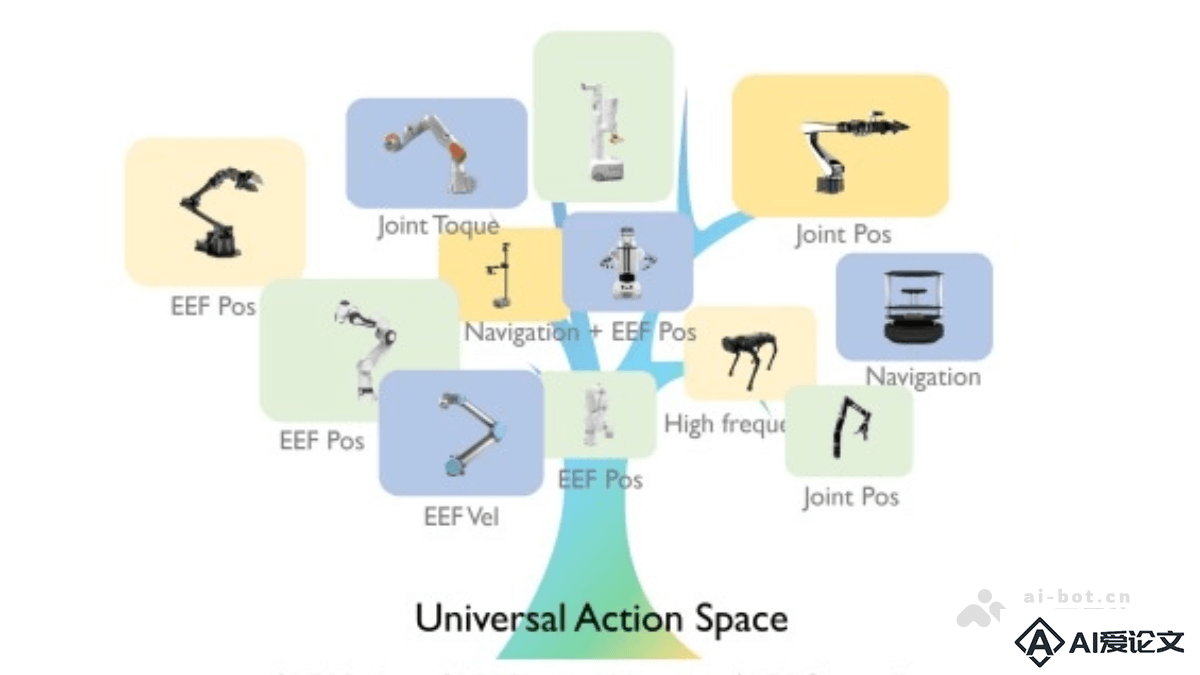

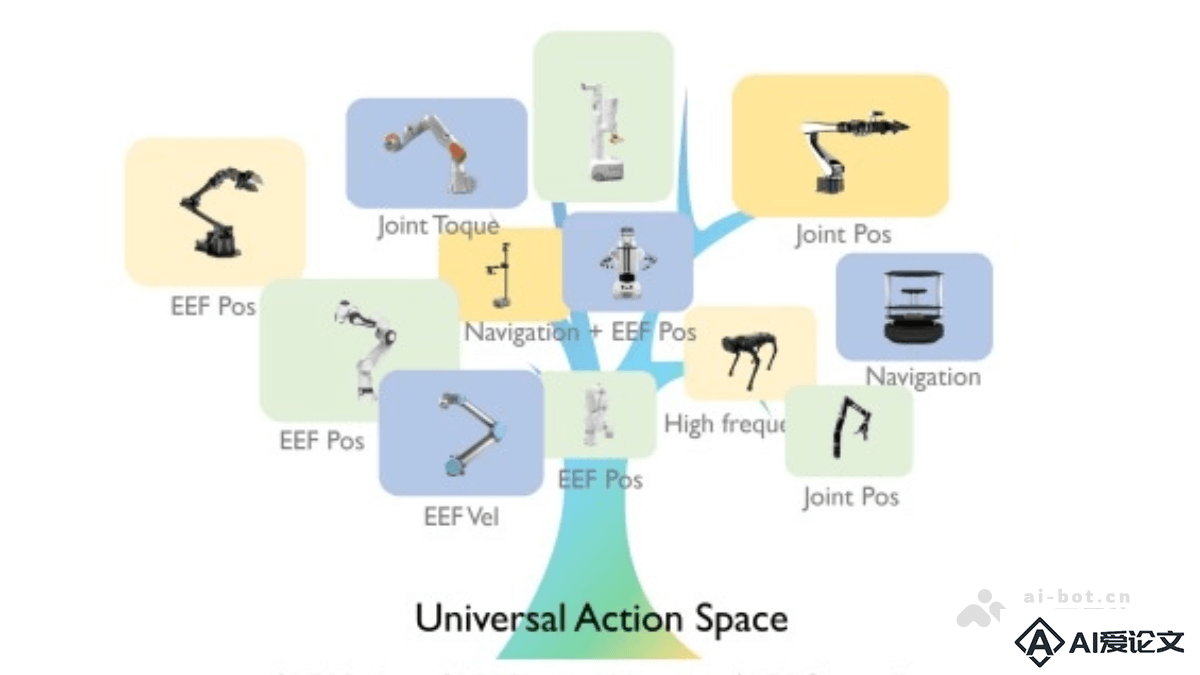

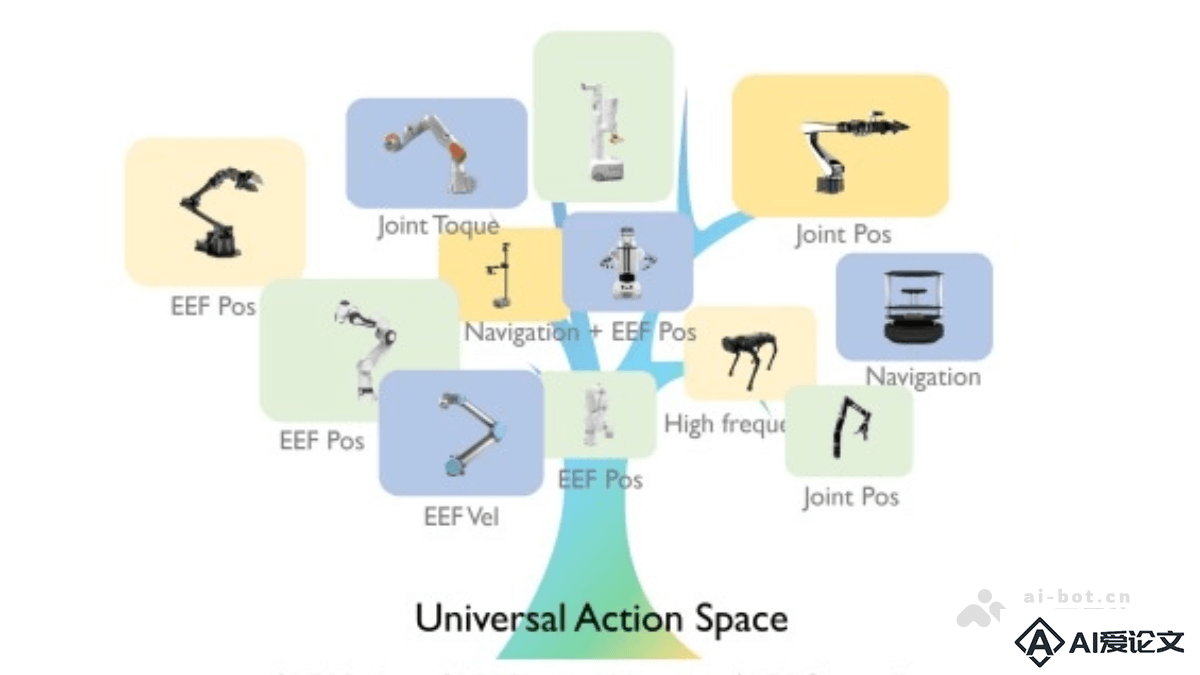

UniAct 是新型的具身基础模型框架,解决不同机器人之间行为异构性的问题。通过学习通用行为,捕捉不同机器人共享的原子行为特征,消除因物理形态和控制接口差异导致的行为异构性。UniAct 的架构包括通用行为提取器、通用行为空间和异构解码器。通用行为提取器基于视觉语言模型,通过观察和任务目标提取通用行为;通用行为空间以向量量化码本形式实现,每个向量代表一种原子行为;异构解码器将通用行为翻译为特定机器人的控制信号。

来源:爱论文 时间:2025-04-21 09:52:39

UniAct 是新型的具身基础模型框架,解决不同机器人之间行为异构性的问题。通过学习通用行为,捕捉不同机器人共享的原子行为特征,消除因物理形态和控制接口差异导致的行为异构性。UniAct 的架构包括通用行为提取器、通用行为空间和异构解码器。通用行为提取器基于视觉语言模型,通过观察和任务目标提取通用行为;通用行为空间以向量量化码本形式实现,每个向量代表一种原子行为;异构解码器将通用行为翻译为特定机器人的控制信号。

相关资讯

更多+

相关资讯

更多+

UniAct 是新型的具身基础模型框架,解决不同机器人之间行为异构性的问题。通过学习通用行为,捕捉不同机器人共享的原子行为特征,消除因物理形态和控制接口差异导致的行为异构性。

AI教程资讯

2023-04-14

2023-04-14

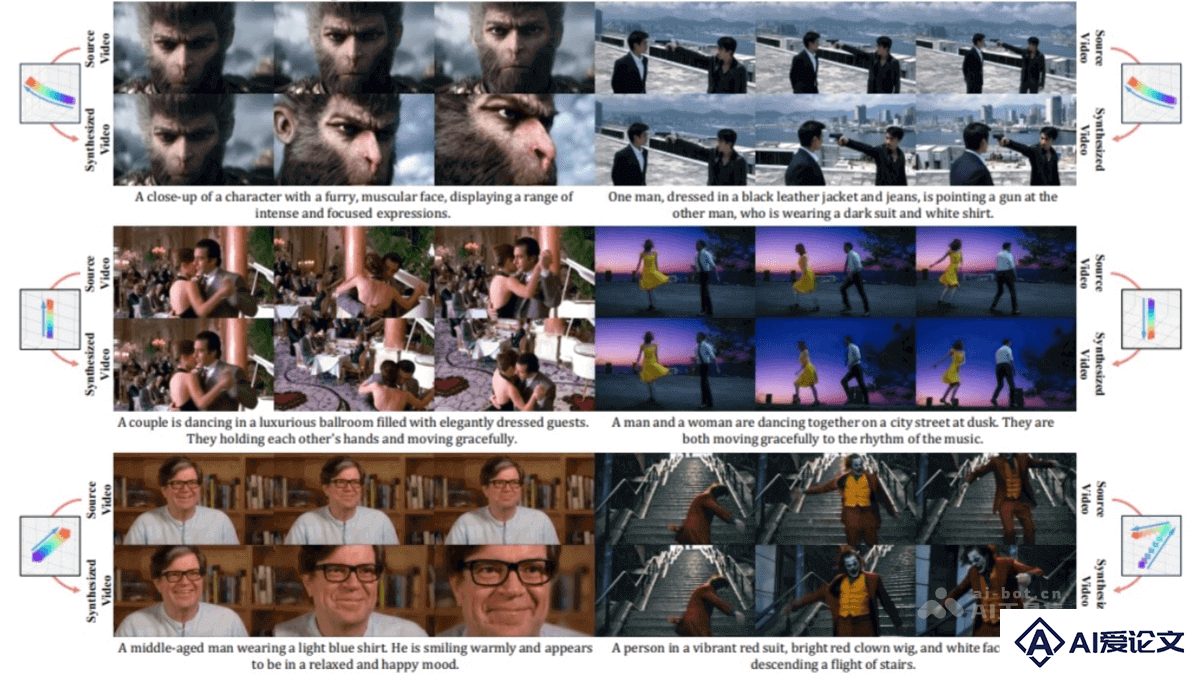

ReCamMaster 是浙江大学、快手科技等联合推出的视频重渲染框架,能根据新的相机轨迹重新生成视频内容。通过预训练模型和帧维度条件机制,结合多相机同步数据集和相机姿态条件,实现视频视角、运动轨迹的灵活调整。

AI教程资讯

2023-04-14

2023-04-14

Stable Virtual Camera 是 Stability AI 推出的 AI 模型,能将 2D 图像转换为具有真实深度和透视感的 3D 视频。用户可以通过指定相机轨迹和多种动态路径(如螺旋、推拉变焦、平移等)来生成视频。模型支持从 1 到 32 张输入图像生成不同宽高比(如 1:1、9:16、16:9)的视频,最长可达 1000 帧。

AI教程资讯

2023-04-14

2023-04-14

Instella是AMD推出的系列30亿参数的开源语言模型。模型完全从零开始在AMD Instinct™ MI300X GPU上训练而成,基于自回归Transformer架构,包含36个解码器层和32个注意力头,支持最长4096个标记的序列。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+