OmniSVG是什么

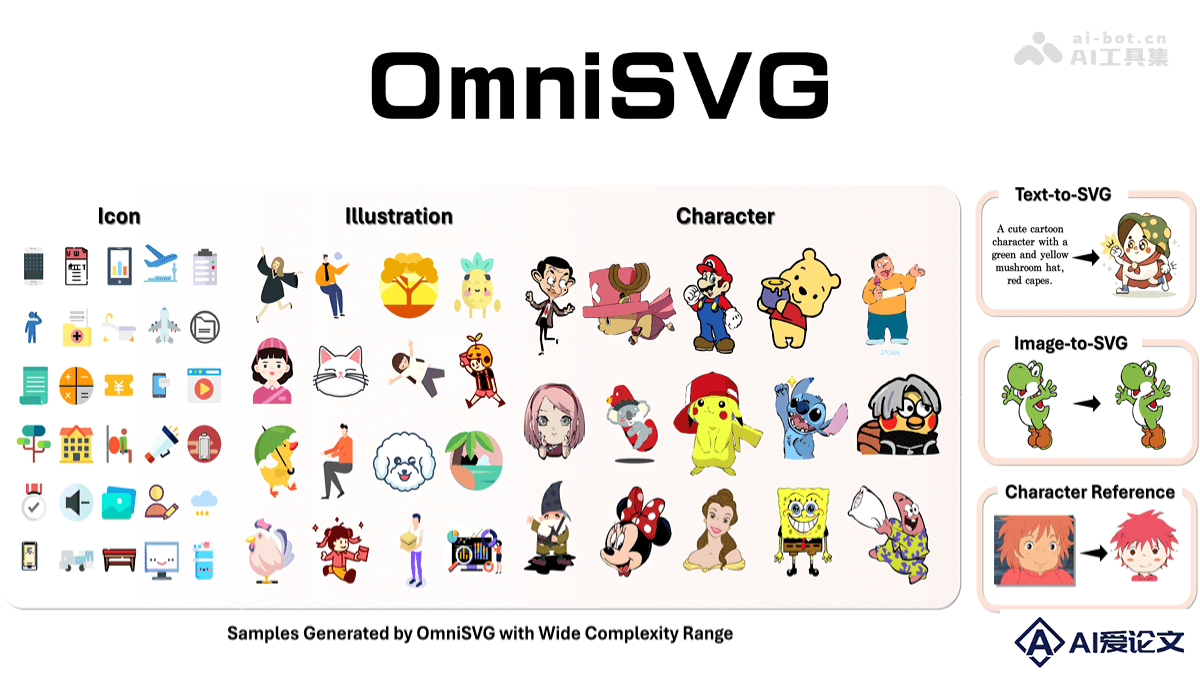

OmniSVG 是复旦大学和 StepFun 联合开发的全球首个端到端多模态 SVG(可缩放矢量图形)生成模型。基于预训练视觉语言模型(VLM),通过创新的 SVG 标记化方法,将 SVG 命令和坐标参数化为离散令牌,实现了结构逻辑与几何细节的解耦。使 OmniSVG 能高效生成从简单图标到复杂动漫角色的多样化高质量 SVG 图形。

来源:爱论文 时间:2025-04-14 12:52:43

OmniSVG 是复旦大学和 StepFun 联合开发的全球首个端到端多模态 SVG(可缩放矢量图形)生成模型。基于预训练视觉语言模型(VLM),通过创新的 SVG 标记化方法,将 SVG 命令和坐标参数化为离散令牌,实现了结构逻辑与几何细节的解耦。使 OmniSVG 能高效生成从简单图标到复杂动漫角色的多样化高质量 SVG 图形。

相关资讯

更多+

相关资讯

更多+

OmniSVG 是复旦大学和 StepFun 联合开发的全球首个端到端多模态 SVG(可缩放矢量图形)生成模型。基于预训练视觉语言模型(VLM),通过创新的 SVG 标记化方法,将 SVG 命令和坐标参数化为离散令牌,实现了结构逻辑与几何细节的解耦。

AI教程资讯

2023-04-14

2023-04-14

A2A(Agent2Agent)是谷歌开源的首个标准智能体交互协议,让不同框架和供应商构建的AI智能体相互协作。A2A基于标准化的通信方式,打破系统孤岛,让智能体安全地交换信息、协调行动。

AI教程资讯

2023-04-14

2023-04-14

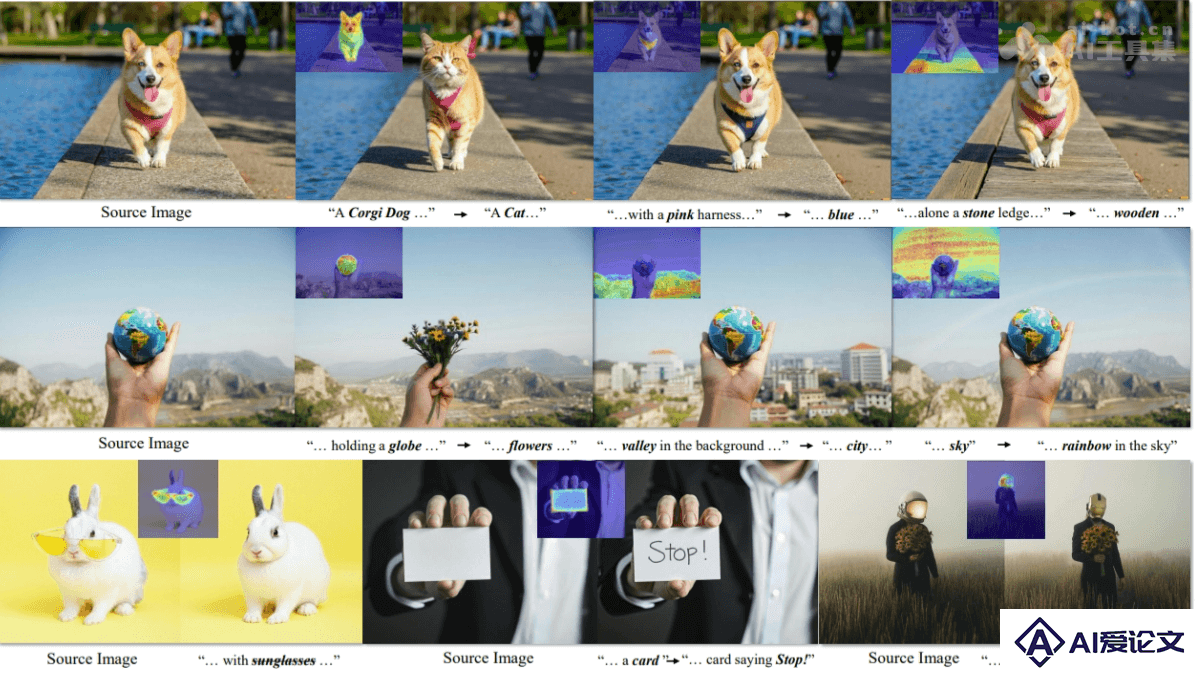

DCEdit 是新型的双层控制图像编辑方法,是北京交通大学和美图2MT实验室联合推出的。DCEdit基于精确语义定位策略(PSL),用视觉和文本自注意力优化交叉注意力图,提供更精准的区域线索指导图像编辑。

AI教程资讯

2023-04-14

2023-04-14

LocAgent是斯坦福大学、耶鲁大学和南加州大学等机构联合推出的,专注于代码定位任务的框架,帮助开发者快速准确地找到代码库中需要修改的部分。LocAgent将代码库解析为有向异构图,捕捉代码的结构和依赖关系,让大型语言模型(LLM)基于强大的多跳推理能力,高效地搜索和定位相关代码实体。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+