FantasyTalking是什么

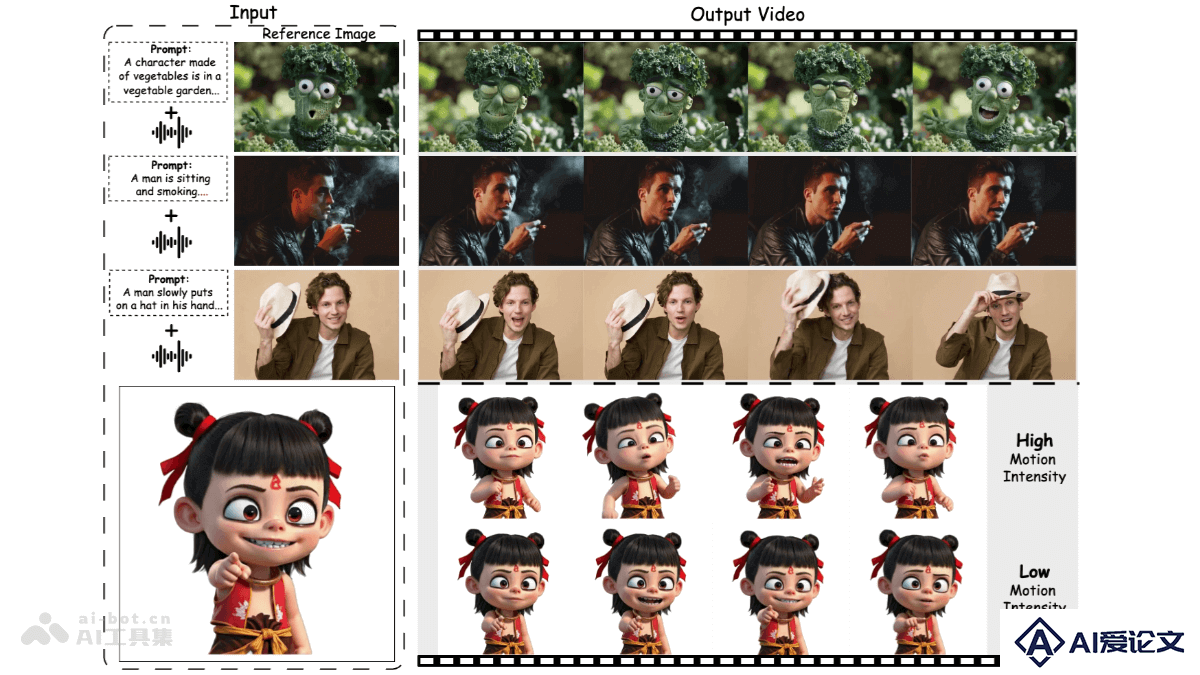

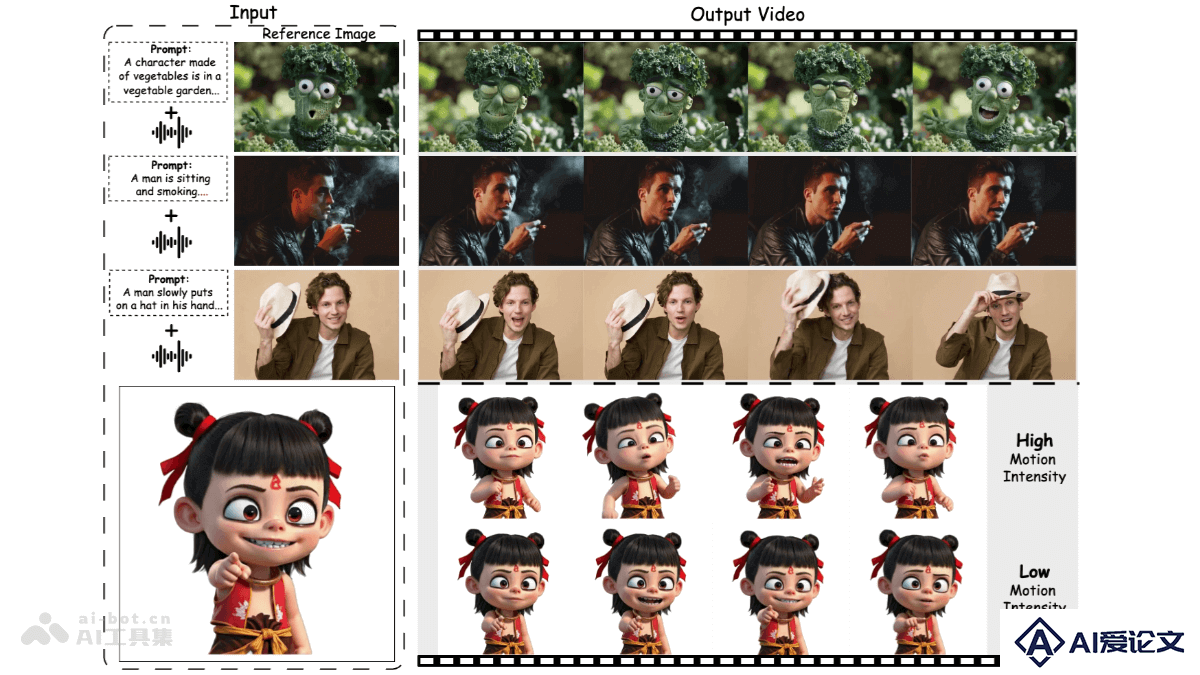

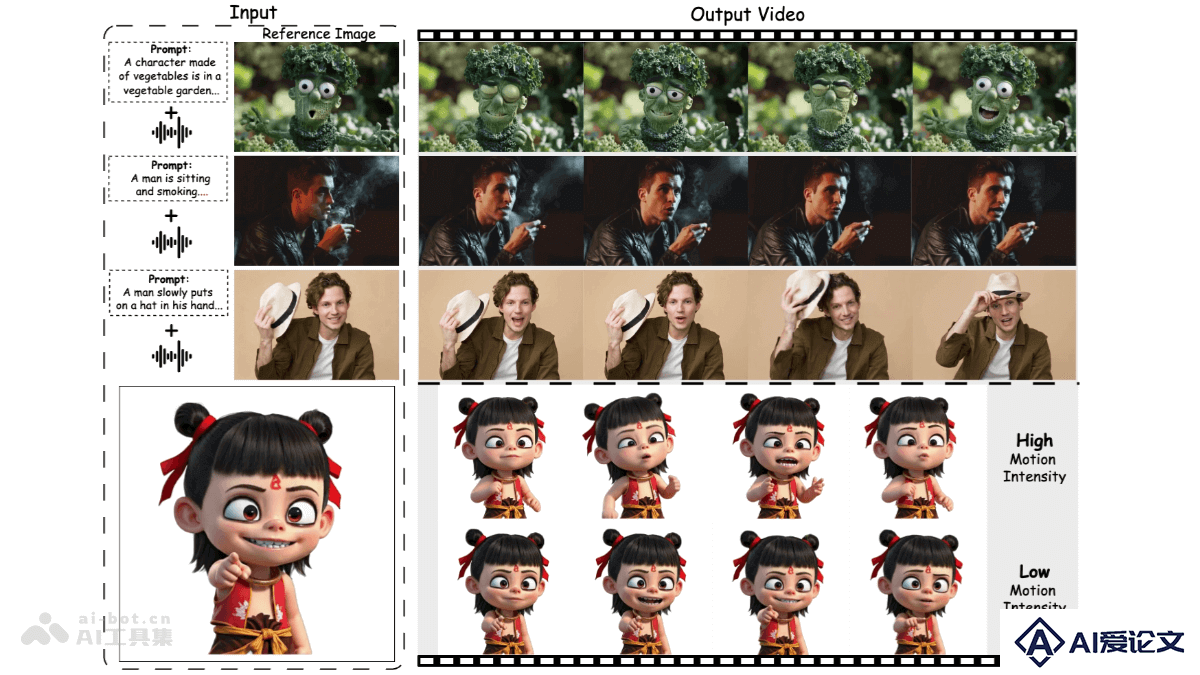

FantasyTalking 是阿里巴巴 AMAP 团队和北京邮电大学联合提出的新型框架,用于从单张静态肖像生成逼真的可动画化虚拟形象。基于预训练的视频扩散变换器模型,采用双阶段视听对齐策略,第一阶段通过片段级训练方案建立连贯的全局运动,第二阶段通过唇部追踪掩码在帧级别细化唇部运动,确保与音频信号精确同步。框架引入面部专注的交叉注意力模块来保持面部一致性,通过运动强度调制模块实现对表情和身体运动强度的控制。

来源:爱论文 时间:2025-04-13 15:13:02

FantasyTalking 是阿里巴巴 AMAP 团队和北京邮电大学联合提出的新型框架,用于从单张静态肖像生成逼真的可动画化虚拟形象。基于预训练的视频扩散变换器模型,采用双阶段视听对齐策略,第一阶段通过片段级训练方案建立连贯的全局运动,第二阶段通过唇部追踪掩码在帧级别细化唇部运动,确保与音频信号精确同步。框架引入面部专注的交叉注意力模块来保持面部一致性,通过运动强度调制模块实现对表情和身体运动强度的控制。

相关资讯

更多+

相关资讯

更多+

FantasyTalking 是阿里巴巴 AMAP 团队和北京邮电大学联合提出的新型框架,用于从单张静态肖像生成逼真的可动画化虚拟形象。基于预训练的视频扩散变换器模型,采用双阶段视听对齐策略,第一阶段通过片段级训练方案建立连贯的全局运动,第二阶段通过唇部追踪掩码在帧级别细化唇部运动,确保与音频信号精确同步。

AI教程资讯

2023-04-14

2023-04-14

BrowseComp 是 OpenAI 开源的用于评估 AI Agent网络浏览能力的基准测试。包含 1266 个极具挑战性的问题,覆盖电影、科学与技术、艺术、历史、体育、音乐、电子游戏等多个领域。需要 AI Agent在互联网上搜索并匹配复杂约束条件,例如找出特定的足球比赛或电视剧角色等。

AI教程资讯

2023-04-14

2023-04-14

日日新SenseNova V6是商汤推出的日日新第六代多模态融合大模型系列,基于6000亿参数的多模态MoE架构,实现文本、图像和视频的原生融合。日日新SenseNova V6在纯文本任务和多模态任务中表现卓越,多项指标超越GPT-4 5、Gemini 2 0 Pro等模型。

AI教程资讯

2023-04-14

2023-04-14

明岐是上海交通大学计算机学院LoCCS实验室推出的首个精准诊断罕见病的医学多模态大模型。基于“大模型能力矩阵 + 专家路由协同”的双引擎驱动架构,整合医学影像、病历文本及化验指标等数据,为医生提供高精度、可解释的诊断支撑。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+