DoraCycle是什么

DoraCycle 是新加坡国立大学 Show Lab 推出多模态领域适应的统一生成模型,通过两个多模态循环(text-to-image-to-text 和 image-to-text-to-image)实现不同模态间的信息转换与对齐,基于统一生成模型学习的双向映射,以非配对数据进行领域适配训练,无需大量标注数据。模型通过循环端点的交叉熵损失优化,促进自我进化,适应特定领域。

来源:爱论文 时间:2025-04-10 16:13:23

DoraCycle 是新加坡国立大学 Show Lab 推出多模态领域适应的统一生成模型,通过两个多模态循环(text-to-image-to-text 和 image-to-text-to-image)实现不同模态间的信息转换与对齐,基于统一生成模型学习的双向映射,以非配对数据进行领域适配训练,无需大量标注数据。模型通过循环端点的交叉熵损失优化,促进自我进化,适应特定领域。

相关资讯

更多+

相关资讯

更多+

DoraCycle 是新加坡国立大学 Show Lab 推出多模态领域适应的统一生成模型,通过两个多模态循环(text-to-image-to-text 和 image-to-text-to-image)实现不同模态间的信息转换与对齐,基于统一生成模型学习的双向映射,以非配对数据进行领域适配训练,无需大量标注数据。

AI教程资讯

2023-04-14

2023-04-14

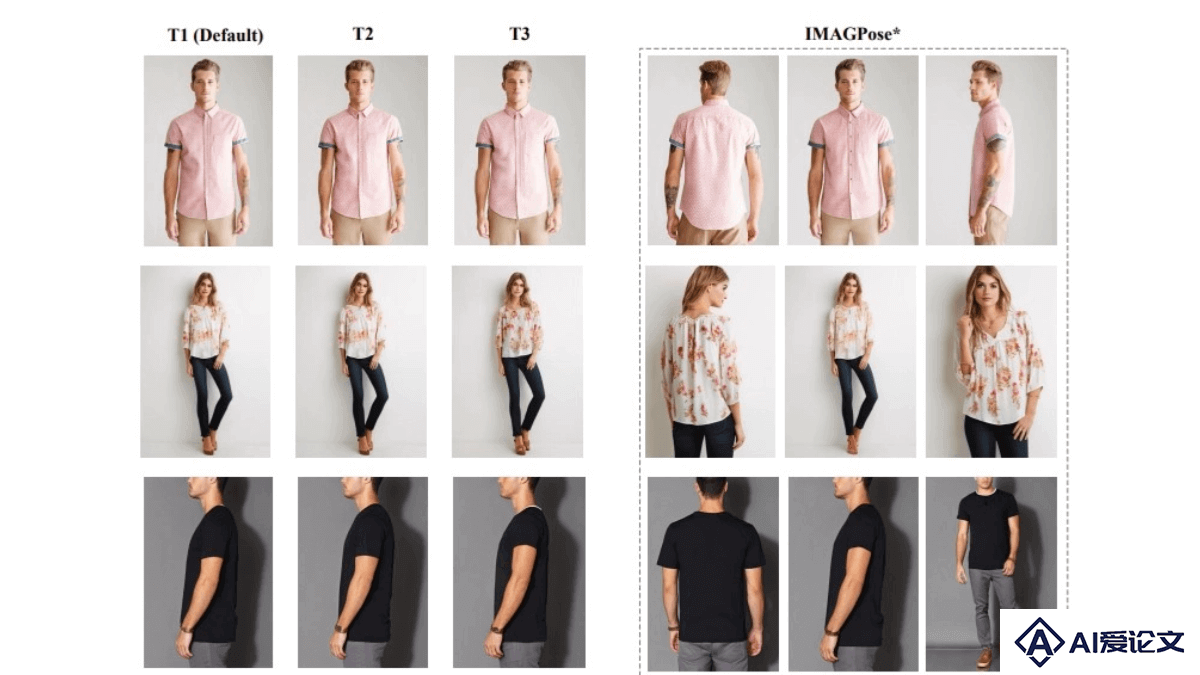

IMAGPose 是南京理工大学推出的用于人体姿态引导图像生成的统一条件框架。解决传统方法在姿态引导的人物图像生成中存在的局限性,如无法同时生成多个不同姿态的目标图像、从多视角源图像生成目标图像受限,以及使用冻结的图像编码器导致人物图像细节信息丢失等问题。

AI教程资讯

2023-04-14

2023-04-14

Heygem 是硅基智能推出的开源数字人模型,专为 Windows 系统设计。基于先进的AI技术,仅需 1 秒视频或 1 张照片,能在 30 秒内完成数字人形象和声音克隆,在 60 秒内合成 4K 超高清视频。Heygem支持多语言输出、多表情动作,具备 100% 口型匹配能力,在复杂光影或遮挡场景下能保持高度逼真的效果。

AI教程资讯

2023-04-14

2023-04-14

LanDiff是用于高质量的文本到视频(T2V)生成的创新混合框架,结合了自回归语言模型(LLM)和扩散模型(Diffusion Model)的优势,通过粗到细的生成方式,有效克服了单一方法在语义理解和视觉质量上的局限性。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+