VE-Bench – 北京大学开源首个针对视频编辑质量评估的新指标

来源:爱论文

时间:2025-01-17 15:57:13

VE-Bench是什么

VE-Bench 是北京大学的研究团队 MMCAL 最近发布首个专门针对视频编辑质量评估的指标。VE-Bench 的设计目标是与人类感知能力高度一致,更准确地评估视频编辑效果。VE-Bench QA 在评估编辑视频时,不仅考虑了传统视频质量评估方法强调的审美、失真等视觉质量指标,还专注于文本与视频的对齐以及源视频与编辑后视频之间的相关性建模。

VE-Bench 包含两个主要部分:VE-Bench DB 和 VE-Bench QA。VE-Bench DB 是一个视频质量评估数据库,包含了丰富的源视频、编辑指令、不同视频编辑模型的编辑结果,以及24名不同背景参与者的主观评分样本,共计28,080个评分样本。VE-Bench QA 是一个量化的、与人类感知一致的度量工具,专门用于文本驱动的视频编辑任务。VE-Bench 的代码和数据可以通过 GitHub 访问。

VE-Bench的主要功能

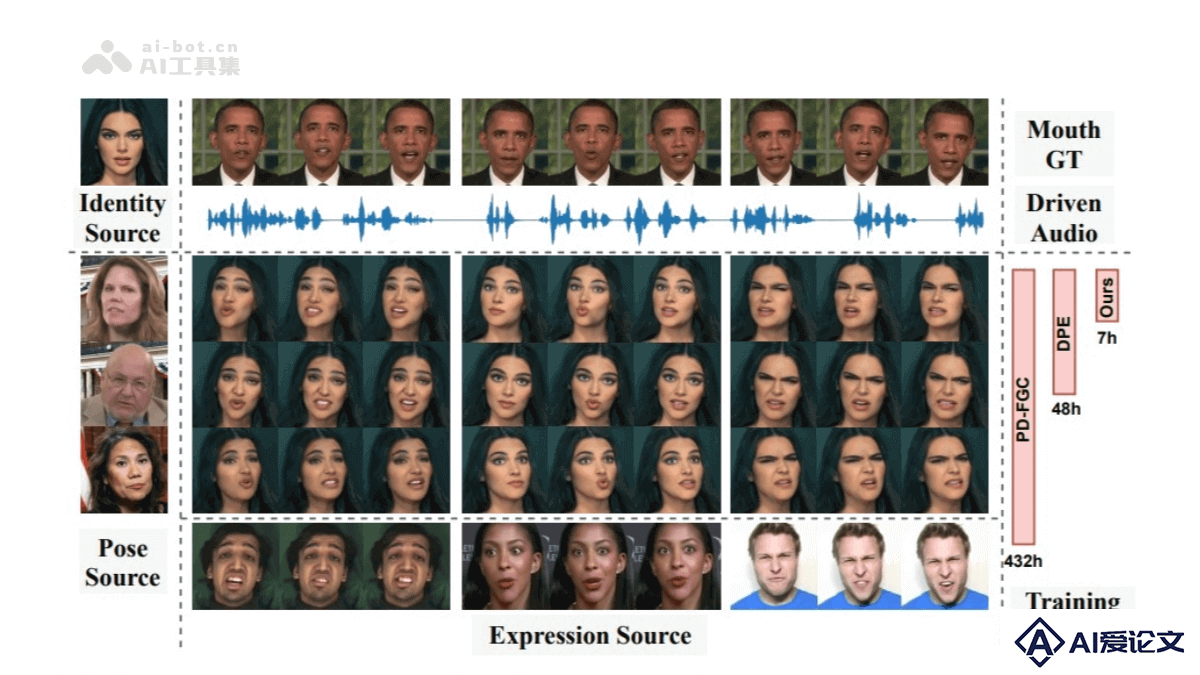

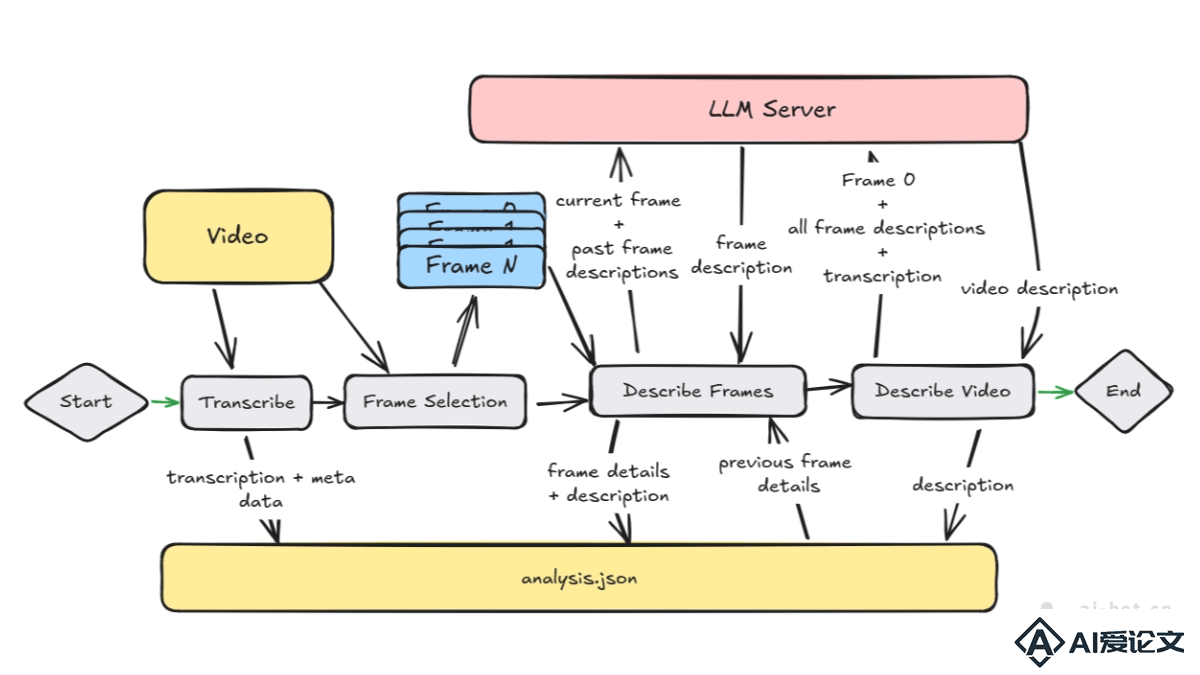

视频质量评估模型(VE-Bench QA):VE-Bench包含一个质量评估模型,旨在为编辑后的视频提供与人类感知一致的度量标准。考虑了传统视频质量评估方法强调的审美、失真等视觉质量指标,还专注于文本与视频的对齐以及源视频与编辑后视频之间的相关性建模。视频质量评估数据库(VE-Bench DB):VE-Bench DB是一个为视频编辑而构建的视频质量评估数据库,包含了丰富的源视频、编辑指令、不同视频编辑模型的编辑结果,以及24名不同背景参与者的主观评分样本,共计28,080个评分样本。文本-视频一致性评估:VE-Bench QA基于BLIP进行视频-文本相关性建模,通过在BLIP视觉分支的基础上加入Temporal Adapter将其扩展到三维,并与文本分支的结果通过交叉注意力得到输出。源视频-编辑后视频动态相关性评估:VE-Bench QA通过时空Transformer将源视频和编辑后视频投影到高维空间,在此基础上拼接后利用注意力机制计算二者相关性,最后通过回归计算得到相应输出。传统视觉质量评估:VE-Bench QA参考了过往自然场景视频质量评价的优秀工作DOVER,通过在美学和失真方面预训练过后的骨干网络输出相应结果。**度评估:VE-Bench QA从文本-视频一致性、源视频-编辑后视频动态相关性以及传统视觉质量三个维度对文本驱动的视频编辑进行评估。

VE-Bench的技术原理

线性层回归:最终各个分支的输出通过线性层回归得到最终分数。深度学习算法:VE-Bench采用了先进的深度学习算法,通过对大量真实世界视频样本的学习,建立了能够模拟人类视觉和听觉系统的模型。多模态学习框架:VE-Bench能同时处理视频中的图像、音频和文本信息,通过大量的真实世界视频样本训练,VE-Bench学会了如何分析视频的技术参数,捕捉那些难以量化的艺术美感和情感表达。

VE-Bench的项目地址

Github仓库:https://github.com/littlespray/VE-BencharXiv技术论文:https://arxiv.org/pdf/2408.11481

VE-Bench的应用场景

电影制作:VE-Bench可以用于电影后期制作中,帮助导演和剪辑师分析每个镜头的颜色、光影效果以及转场是否符合预期,确保影片的情感氛围得到准确传达。短视频平台内容优化:短视频创作者可以用VE-Bench实时监测视频的视觉效果、音频质量和叙事结构,根据系统的建议进行优化,提升视频的整体观感和互动率。广告行业精准营销:VE-Bench能分析视频内容,帮助广告行业进行精准营销,确保广告视频与目标受众的情感和视觉预期相匹配。视频编辑质量评估:VE-Bench关注视频编辑前后结果与原始视频之间的联系,例如“摘掉女孩的耳环”的任务中,需要保留人物ID,源视频与编辑结果应该有着较强语义相关性。

相关资讯

相关资讯 2023-04-14

2023-04-14

下载

下载