GameFactory是什么

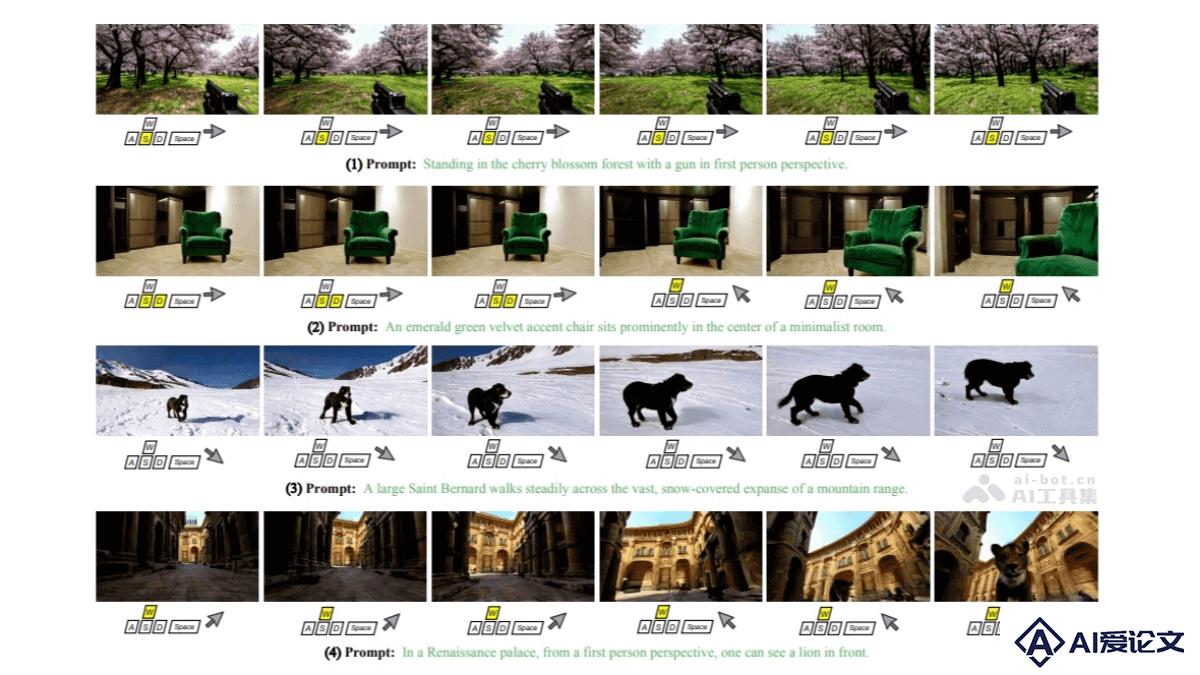

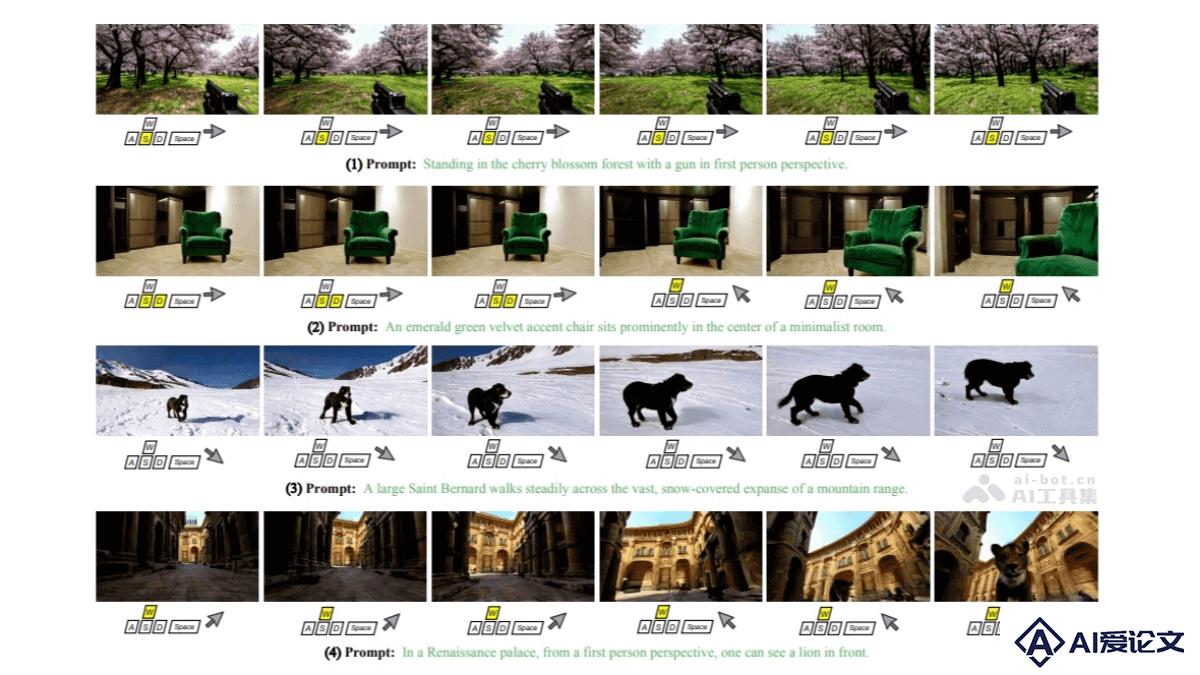

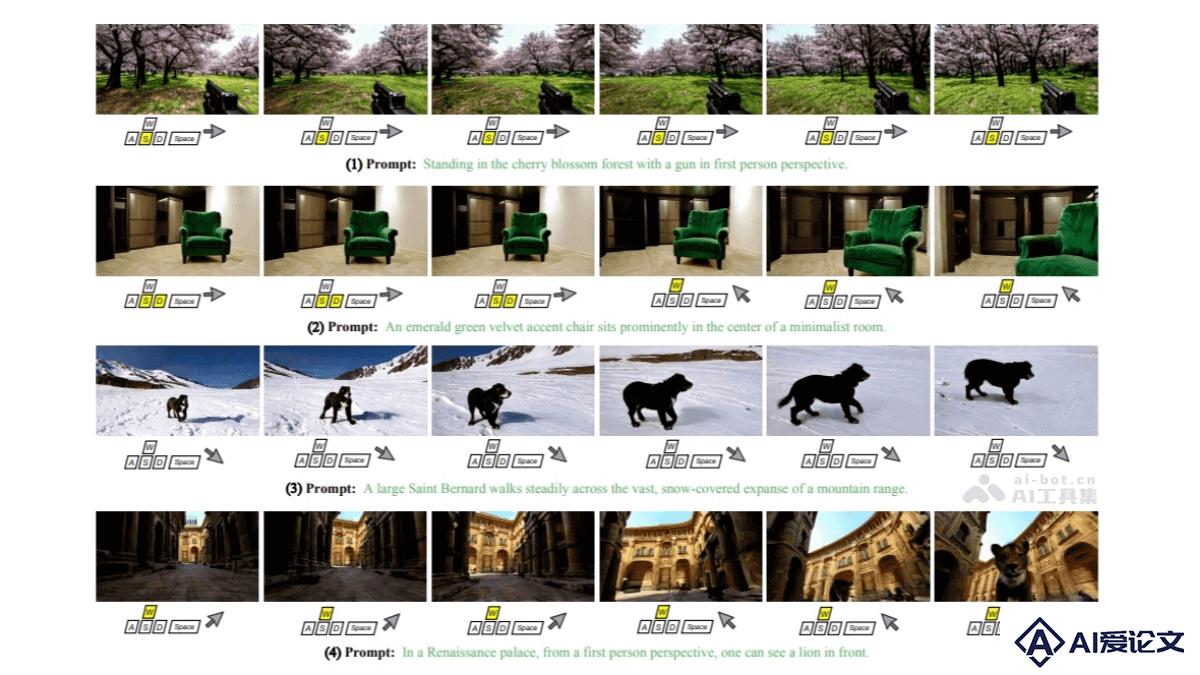

GameFactory 是香港大学和快手科技联合提出的创新框架,解决游戏视频生成中的场景泛化难题。框架基于预训练的视频扩散模型,结合开放域视频数据和小规模高质量的游戏数据集,通过多阶段训练策略,实现动作可控的游戏视频生成。

来源:爱论文 时间:2025-03-27 16:51:01

GameFactory 是香港大学和快手科技联合提出的创新框架,解决游戏视频生成中的场景泛化难题。框架基于预训练的视频扩散模型,结合开放域视频数据和小规模高质量的游戏数据集,通过多阶段训练策略,实现动作可控的游戏视频生成。

相关资讯

更多+

相关资讯

更多+

GameFactory 是香港大学和快手科技联合提出的创新框架,解决游戏视频生成中的场景泛化难题。框架基于预训练的视频扩散模型,结合开放域视频数据和小规模高质量的游戏数据集,通过多阶段训练策略,实现动作可控的游戏视频生成。

AI教程资讯

2023-04-14

2023-04-14

Step-2 mini 是阶跃星辰推出的轻量级极速大模型,基于新一代自研 Attention 架构 MFA 开发。仅用 3% 的参数量就保留了 Step-2 超过 80% 的性能,显著提升了生成速度和性价比。

AI教程资讯

2023-04-14

2023-04-14

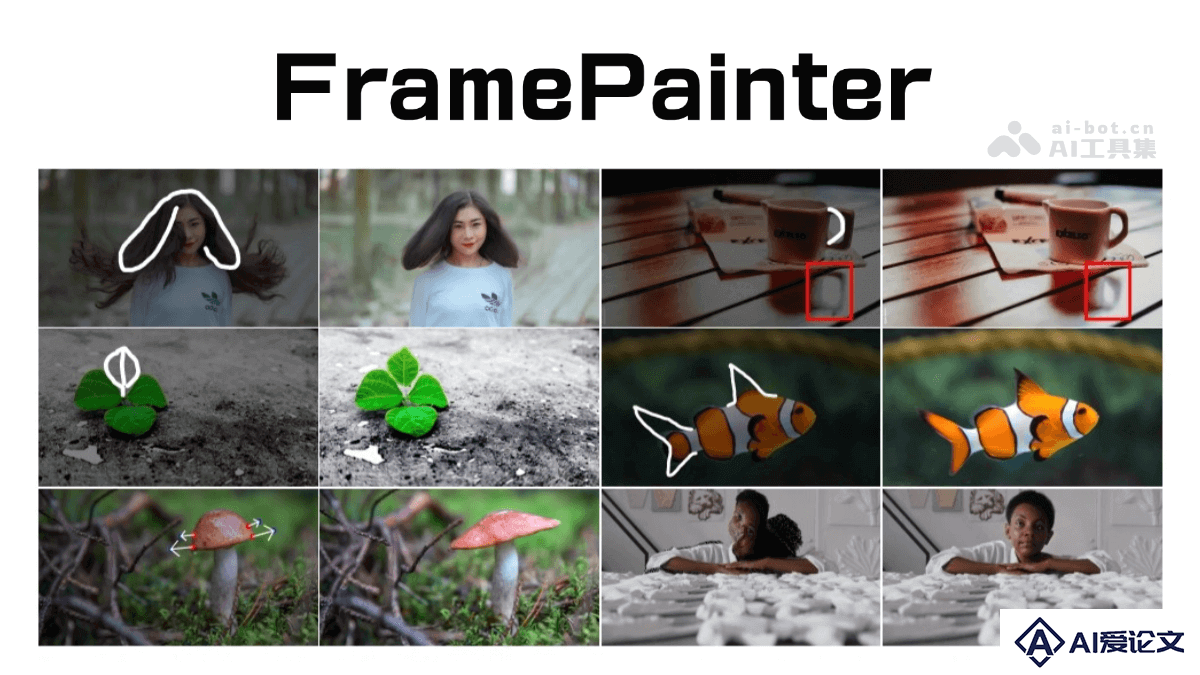

FramePainter 是基于 AI 的交互式图像编辑工具,通过结合视频扩散模型和直观的草图控制,让用户能通过简单的绘制、点击或拖动操作来指示编辑意图,实现对图像的精确修改。

AI教程资讯

2023-04-14

2023-04-14

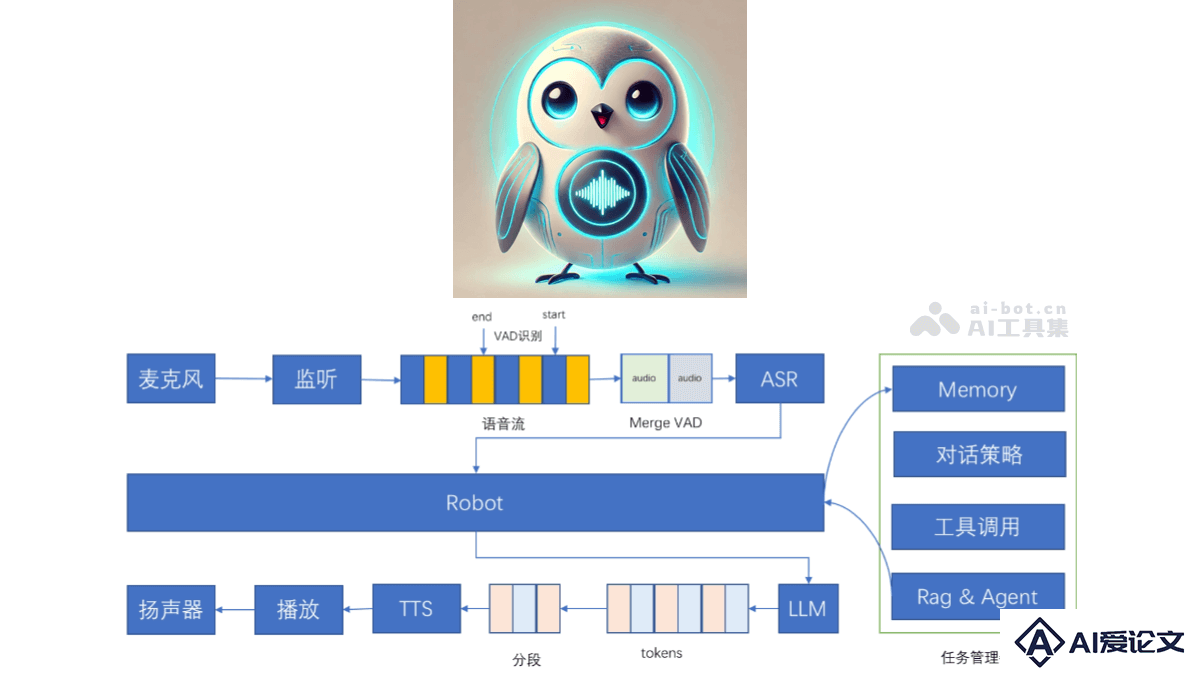

百聆(Bailing)是开源的语音对话助手,基于语音识别(ASR)、语音活动检测(VAD)、大语言模型(LLM)和语音合成(TTS)技术实现与用户的自然语音对话,实现类GPT-4o的对话效果。百聆无需GPU即可运行,端到端时延低至800ms,适用于各种边缘设备和低资源环境。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+