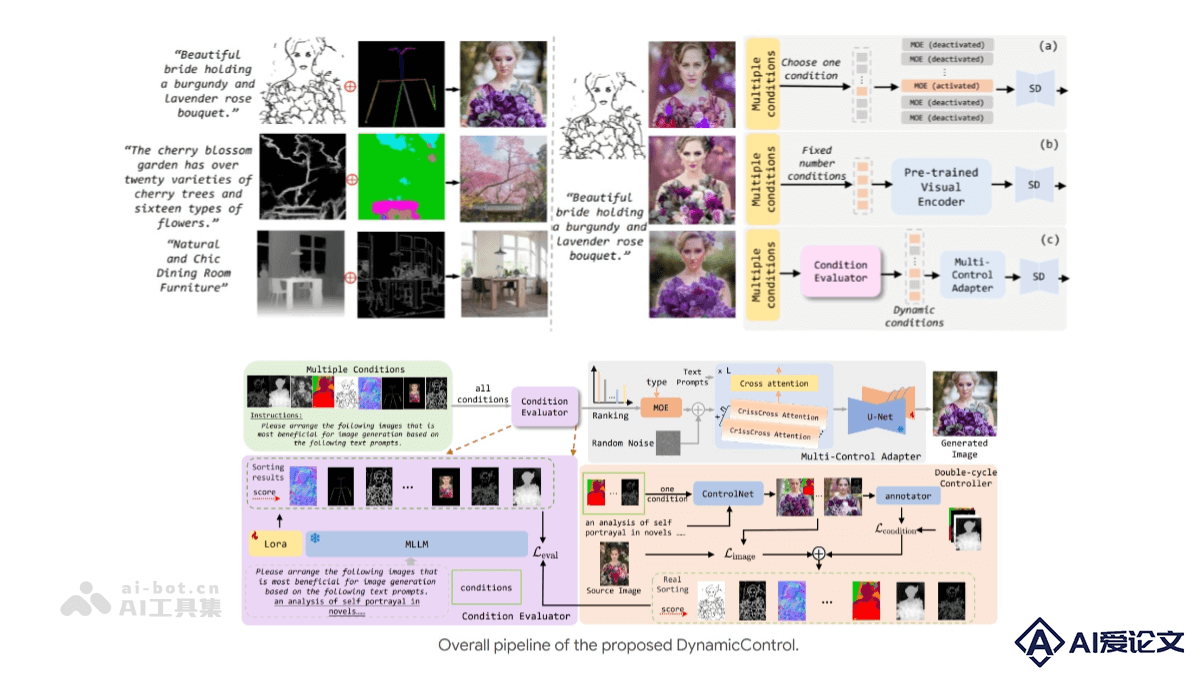

DynamicControl是什么

DynamicControl是腾讯优图联合南洋理工、浙大等研究机构推出的集成多模态大语言模型(MLLM)推理能力的文本生成图像(T2I)任务新框架。DynamicControl通过自适应地选择不同条件,实现了动态多控制对齐,显著增强了图像生成的可控性,同时保持了图像质量和图像文本对齐。架构支持多种控制信号的动态组合,能根据条件的重要性和内部关系自适应选择不同数量和类型的条件,优化了生成更接近源图像的图像。

来源:爱论文 时间:2025-01-17 12:39:55

DynamicControl是腾讯优图联合南洋理工、浙大等研究机构推出的集成多模态大语言模型(MLLM)推理能力的文本生成图像(T2I)任务新框架。DynamicControl通过自适应地选择不同条件,实现了动态多控制对齐,显著增强了图像生成的可控性,同时保持了图像质量和图像文本对齐。架构支持多种控制信号的动态组合,能根据条件的重要性和内部关系自适应选择不同数量和类型的条件,优化了生成更接近源图像的图像。

相关资讯

更多+

相关资讯

更多+

DynamicControl是腾讯优图联合南洋理工、浙大等研究机构推出的集成多模态大语言模型(MLLM)推理能力的文本生成图像(T2I)任务新框架。DynamicControl通过自适应地选择不同条件,实现了动态多控制对齐,显著增强了图像生成的可控性,同时保持了图像质量和图像文本对齐。

AI教程资讯

2023-04-14

2023-04-14

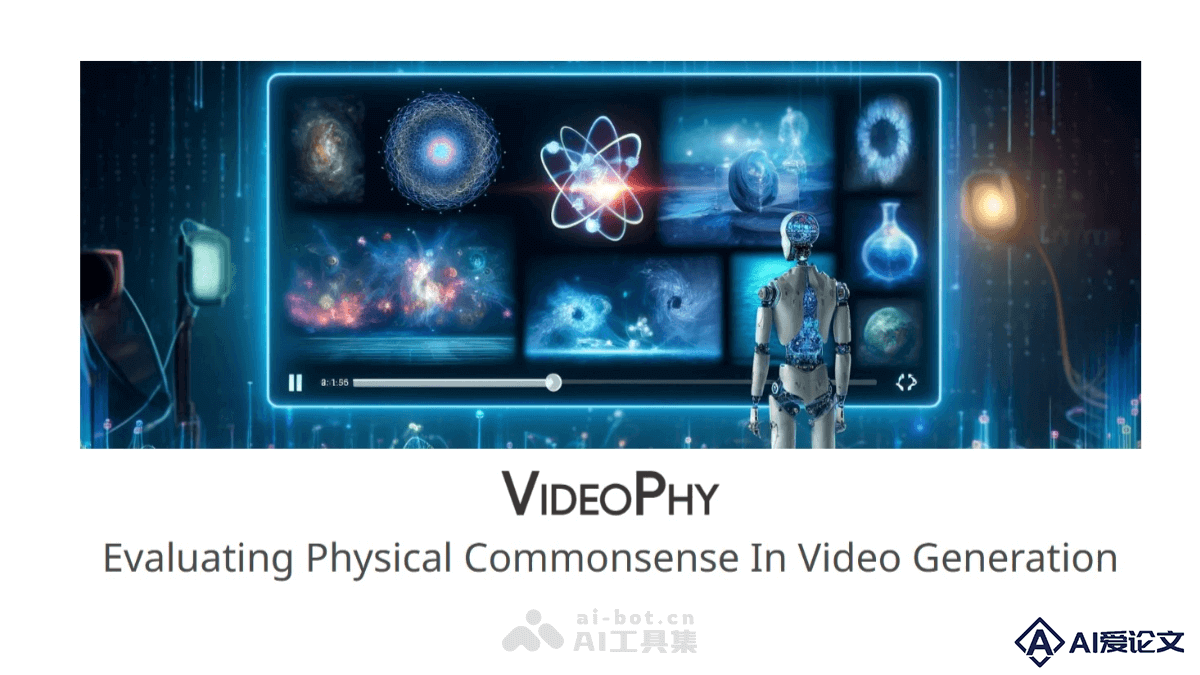

VideoPhy是UCLA和谷歌研究研究院联合推出的,首个评估视频生成模型物理常识能力的基准测试,能衡量模型生成的视频是否遵循现实世界的物理规则。VideoPhy基准包含688个描述物理互动的字幕,用在从多种文本到视频模型中生成视频,进行人类及自动评估。

AI教程资讯

2023-04-14

2023-04-14

Large Motion Model(LMM)是统一的多模态运动生成模型,是新加坡南洋理工大学S-Lab和商汤科技研究团队共同推出的。LMM能处理包括文本到运动、音乐到舞蹈等多种运动生成任务,在多个基准测试中展现出与专家模型相媲美的性能。

AI教程资讯

2023-04-14

2023-04-14

StereoCrafter是腾讯AI Lab和ARC Lab共同推出的创新框架,能将单目视频(2D视频)转换为立体3D视频,满足日益增长的3D内容需求。StereoCrafter基于深度估计、视频splatting和立体视频修复三个核心步骤,实现高保真度的2D到3D视频转换。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+

AI工具推荐

更多+

AI工具推荐

更多+