EMO2是什么

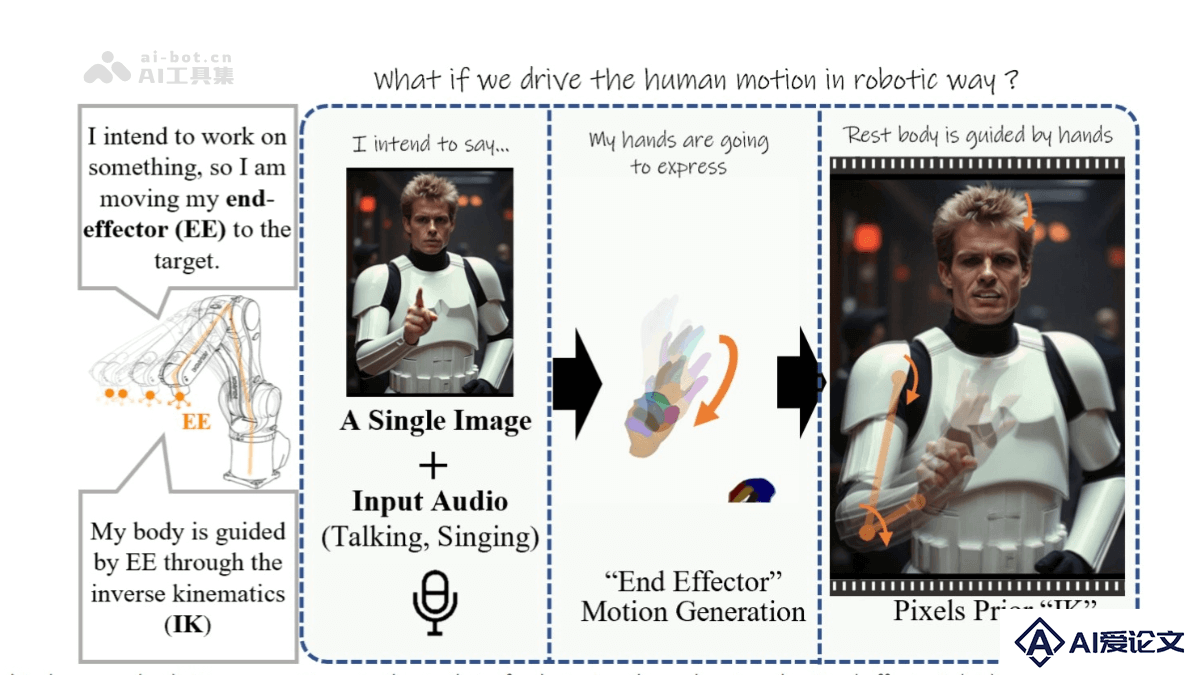

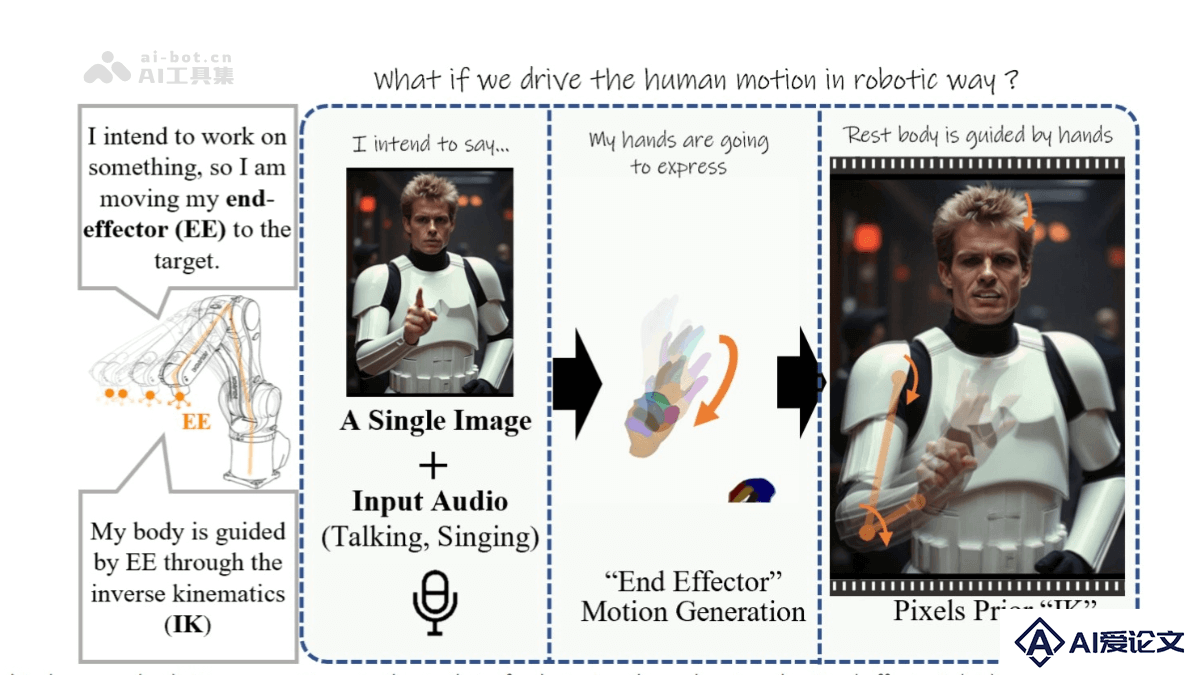

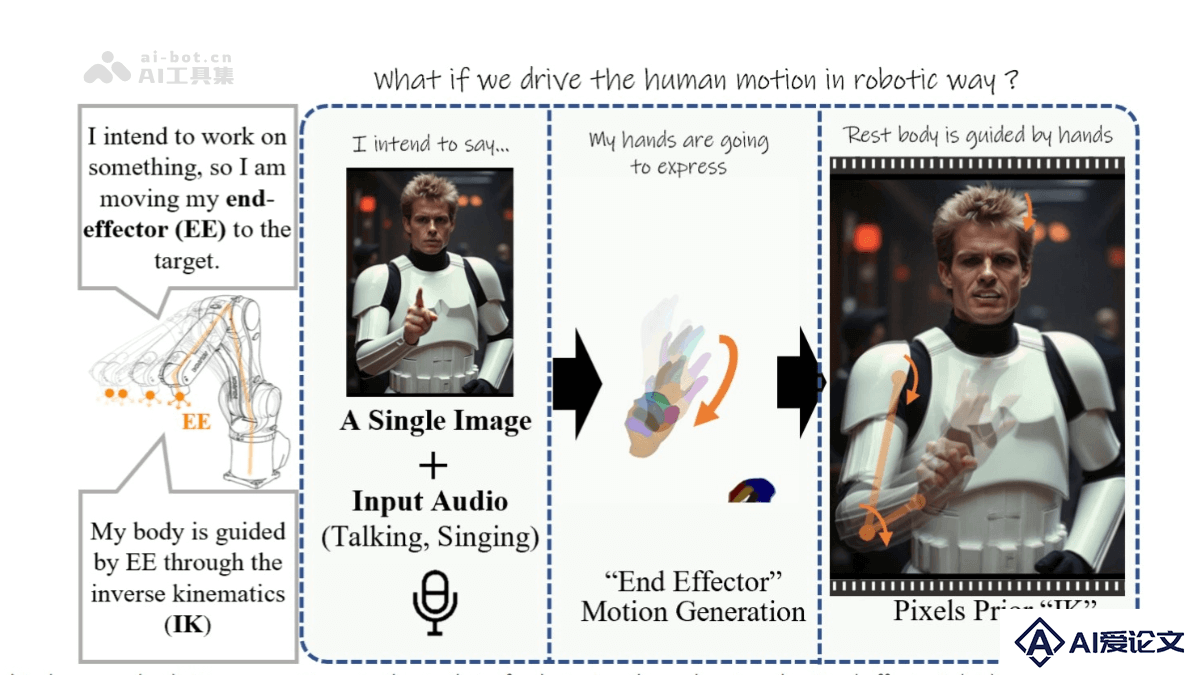

EMO2 (End-Effector Guided Audio-Driven Avatar Video Generation)是阿里巴巴智能计算研究院开发的音频驱动头像视频生成技术,全称为“末端效应器引导的音频驱动头像视频生成”。通过音频输入和一张静态人像照片,生成富有表现力的动态视频。核心创新在于将音频信号与手部动作和面部表情相结合,通过扩散模型合成视频帧,生成自然流畅的动画。 包括高质量的视觉效果、高精度的音频同步以及丰富的动作多样性。

来源:爱论文 时间:2025-03-26 13:50:54

EMO2 (End-Effector Guided Audio-Driven Avatar Video Generation)是阿里巴巴智能计算研究院开发的音频驱动头像视频生成技术,全称为“末端效应器引导的音频驱动头像视频生成”。通过音频输入和一张静态人像照片,生成富有表现力的动态视频。核心创新在于将音频信号与手部动作和面部表情相结合,通过扩散模型合成视频帧,生成自然流畅的动画。 包括高质量的视觉效果、高精度的音频同步以及丰富的动作多样性。

相关资讯

更多+

相关资讯

更多+

EMO2 (End-Effector Guided Audio-Driven Avatar Video Generation)是阿里巴巴智能计算研究院开发的音频驱动头像视频生成技术,全称为“末端效应器引导的音频驱动头像视频生成”。通过音频输入和一张静态人像照片,生成富有表现力的动态视频。

AI教程资讯

2023-04-14

2023-04-14

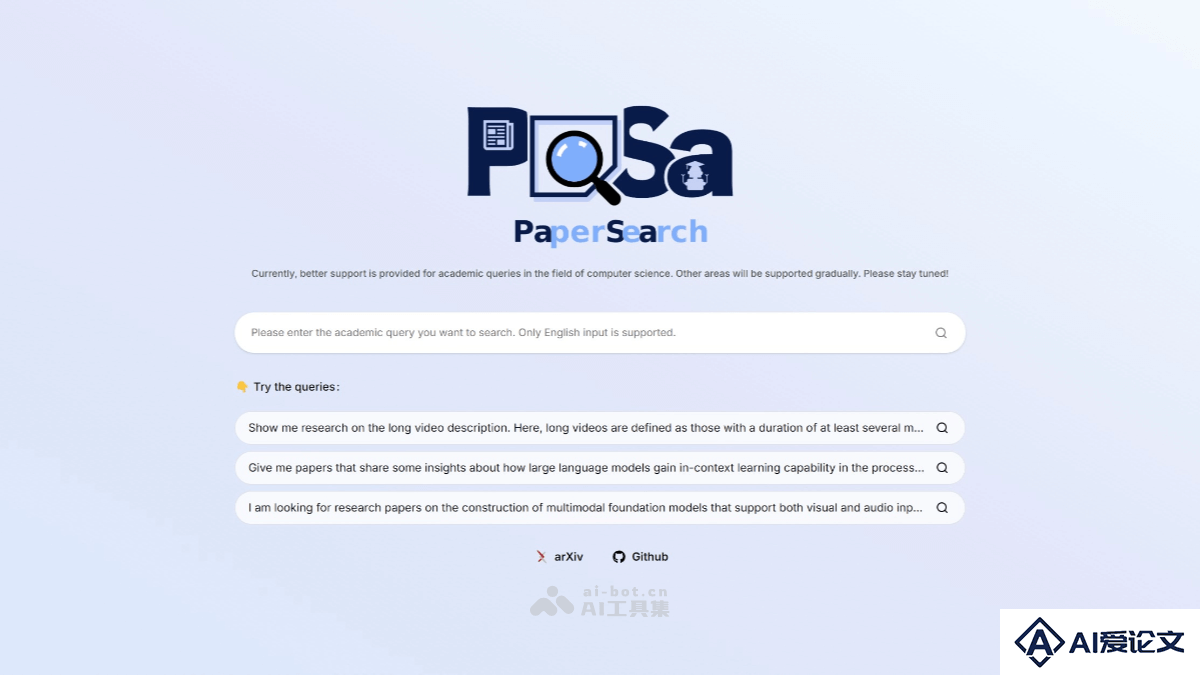

PaSa是字节跳动研究团队(ByteDance Research)推出的基于强化学习的学术论文检索智能体。能模仿人类研究者的行为,自动调用搜索引擎、浏览相关论文并追踪引文网络,为用户提供精准、全面的学术论文检索结果。

AI教程资讯

2023-04-14

2023-04-14

Baichuan-M1-preview 是百川智能推出的国内首个全场景深度思考模型。模型具备语言、视觉和搜索三大领域的推理能力,在数学、代码等多个权威评测中表现优异,超越了o1-preview等模型。核心亮点是解锁了“医疗循证模式”,通过自建的亿级条目循证医学知识库,能快速、精准地回答医疗临床和科研问题。

AI教程资讯

2023-04-14

2023-04-14

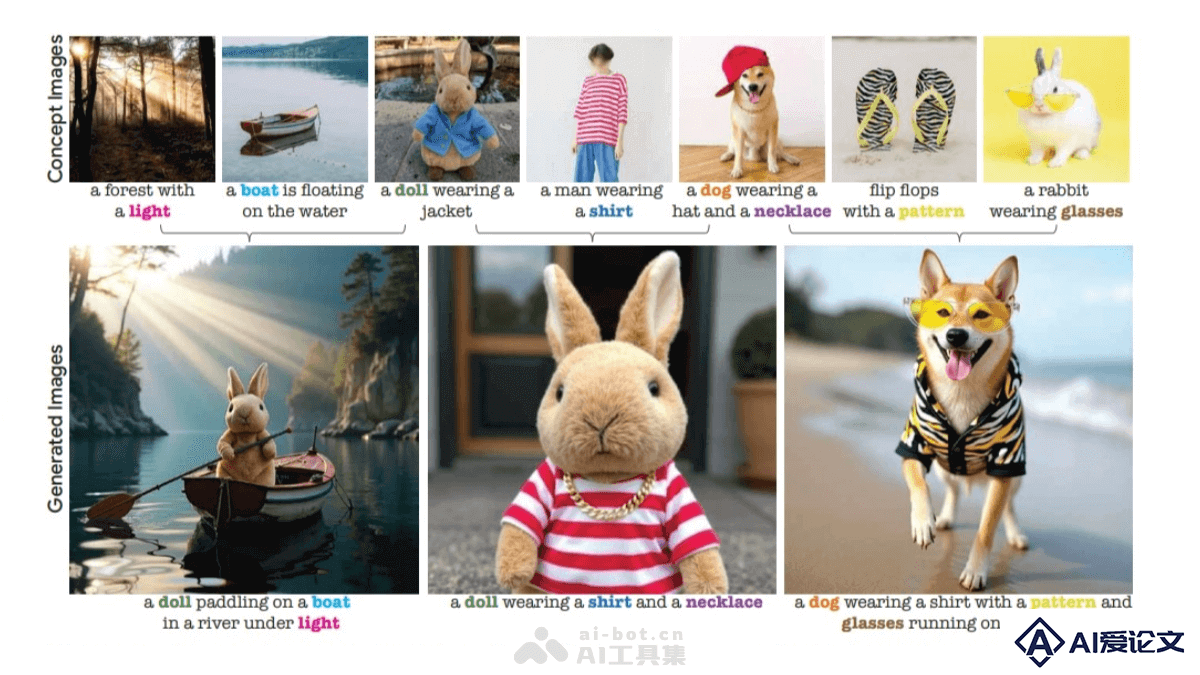

TokenVerse 是基于预训练文本到图像扩散模型的多概念个性化图像生成方法。能从单张图像中解耦复杂的视觉元素和属性,从多张图像中提取概念进行无缝组合生成。支持多种概念,包括物体、配饰、材质、姿势和光照等,突破了现有技术在概念类型或广度上的限制。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+