Janus-Pro是什么

Janus-Pro是 DeepSeek 推出的开源AI模型,支持图像理解和图像生成,提供 1B 和 7B 两种规模,适配多元应用场景。通过改进的训练策略、扩展的数据集和更大规模的模型,显著提升了文本到图像的生成能力和指令跟随性能。Janus-Pro 采用解耦的视觉编码路径,提升了多模态任务的灵活性,在图像生成任务中表现出较高的稳定性和精准度,成为一个强大的统一多模态模型。

来源:爱论文 时间:2025-03-25 15:19:21

Janus-Pro是 DeepSeek 推出的开源AI模型,支持图像理解和图像生成,提供 1B 和 7B 两种规模,适配多元应用场景。通过改进的训练策略、扩展的数据集和更大规模的模型,显著提升了文本到图像的生成能力和指令跟随性能。Janus-Pro 采用解耦的视觉编码路径,提升了多模态任务的灵活性,在图像生成任务中表现出较高的稳定性和精准度,成为一个强大的统一多模态模型。

相关资讯

更多+

相关资讯

更多+

Janus-Pro是 DeepSeek 推出的开源AI模型,支持图像理解和图像生成,提供 1B 和 7B 两种规模,适配多元应用场景。通过改进的训练策略、扩展的数据集和更大规模的模型,显著提升了文本到图像的生成能力和指令跟随性能。

AI教程资讯

2023-04-14

2023-04-14

Qwen2 5-VL是阿里通义千问团队开源的旗舰视觉语言模型,具有3B、7B和72B三种不同规模。模型在视觉理解方面表现出色,能识别常见物体,分析图像中的文本、图表等元素。Qwen2 5-VL具备作为视觉Agent的能力,可以推理并动态使用工具,能初步操作电脑和手机。

AI教程资讯

2023-04-14

2023-04-14

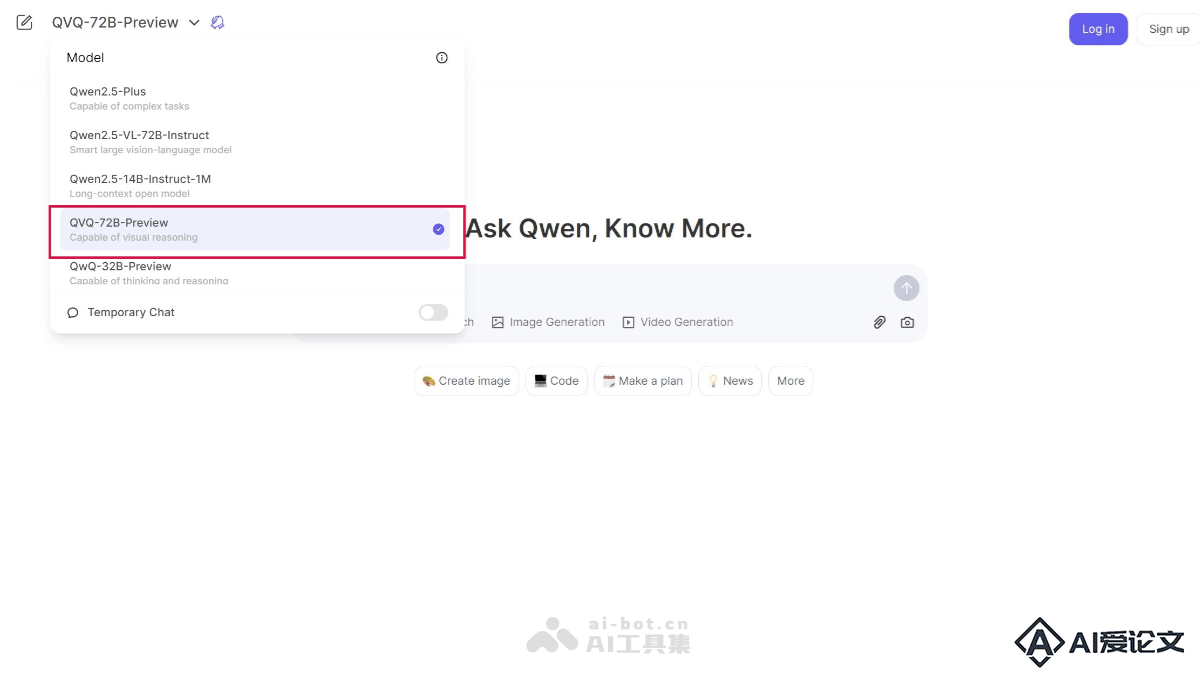

QVQ-72B-Preview 是阿里云通义千问团队开源的多模态推理模型,专注于提升视觉推理能力。模型在多个基准测试中表现出色,在多模态理解和推理任务上展现了强大的能力。

AI教程资讯

2023-04-14

2023-04-14

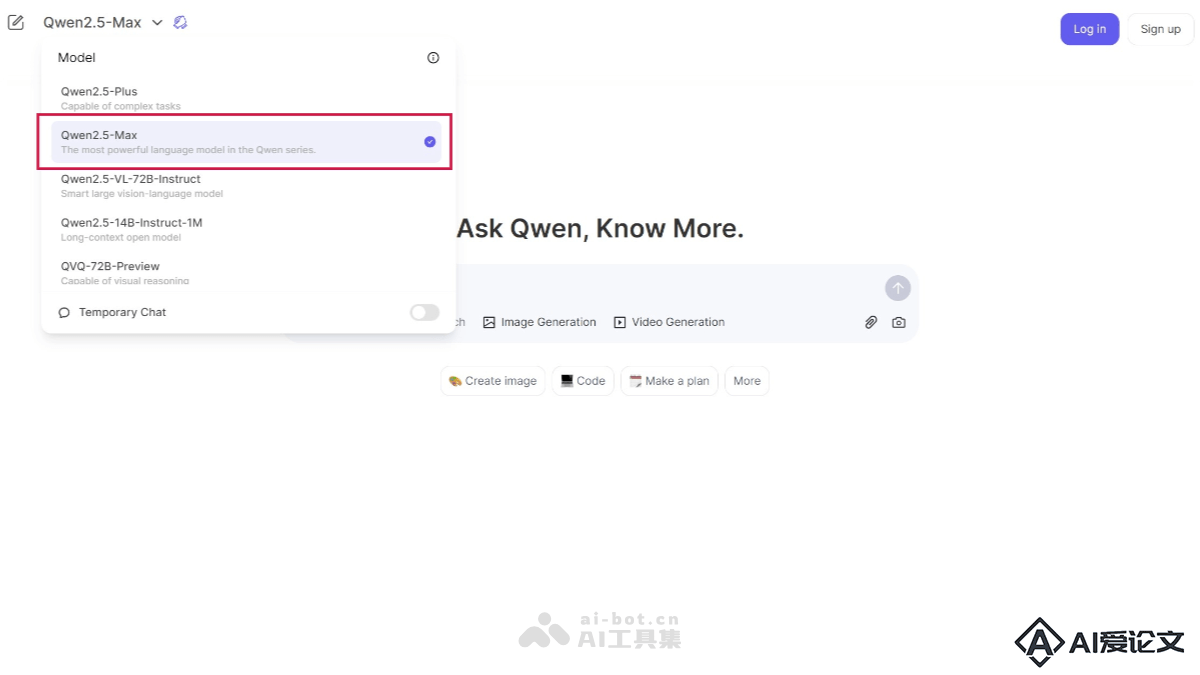

Qwen2 5-Max是阿里云推出的超大规模MoE(Mixture of Experts)模型,使用超过20万亿tokens的预训练数据。模型在多个基准测试中表现卓越,超越了DeepSeek V3、Llama-3 1-405B等领先模型。

AI教程资讯

2023-04-14

2023-04-14

热门推荐

更多+

热门推荐

更多+